Curso IA

Bloque 3 · Arquitectura

Cómo está construida la IA por dentro

Hasta ahora hemos entendido qué es la inteligencia artificial, por qué surge, y cómo aprende una máquina a partir de datos. En este punto del curso, ya no estamos hablando de usos ni de promesas, sino de fundamentos sólidos. El siguiente paso lógico es mirar hacia dentro y responder a una pregunta clave: qué estructura hace posible todo lo que hemos visto hasta ahora.

Este bloque se centra en la arquitectura interna de la IA moderna. No en cómo se usa, ni en cómo se le habla, ni en lo que “parece” hacer, sino en cómo está construida para poder aprender, ajustarse y producir resultados útiles. Aquí desmontamos la idea de la IA como algo difuso o mágico y la sustituimos por una visión clara: sistemas formados por estructuras concretas, con reglas internas muy distintas a las humanas.

A lo largo de estos capítulos veremos qué es una red neuronal artificial, cómo se convierte en algo funcional mediante el entrenamiento, qué aporta la profundidad en los modelos modernos y por qué esa misma complejidad introduce límites inevitables. También entenderemos por qué muchos sistemas de IA son difíciles de explicar por dentro y por qué esa opacidad no es un fallo accidental, sino una consecuencia directa de su diseño.

Este bloque no busca que memorices términos técnicos ni fórmulas, sino que construyas un mapa mental correcto de cómo funciona la IA “por dentro”. Un mapa que te permitirá entender mejor sus capacidades reales, sus fragilidades y por qué, más adelante, aparecen fenómenos como la falta de explicabilidad o la dificultad para generalizar fuera de lo aprendido.

Con este marco, estamos listos para entrar en la arquitectura sin mitos, sin humanizaciones y sin atajos. A partir del próximo capítulo, empezamos a desmontar la máquina pieza a pieza.

CAPÍTULO 11

Qué es una red neuronal

Resumen del capítulo

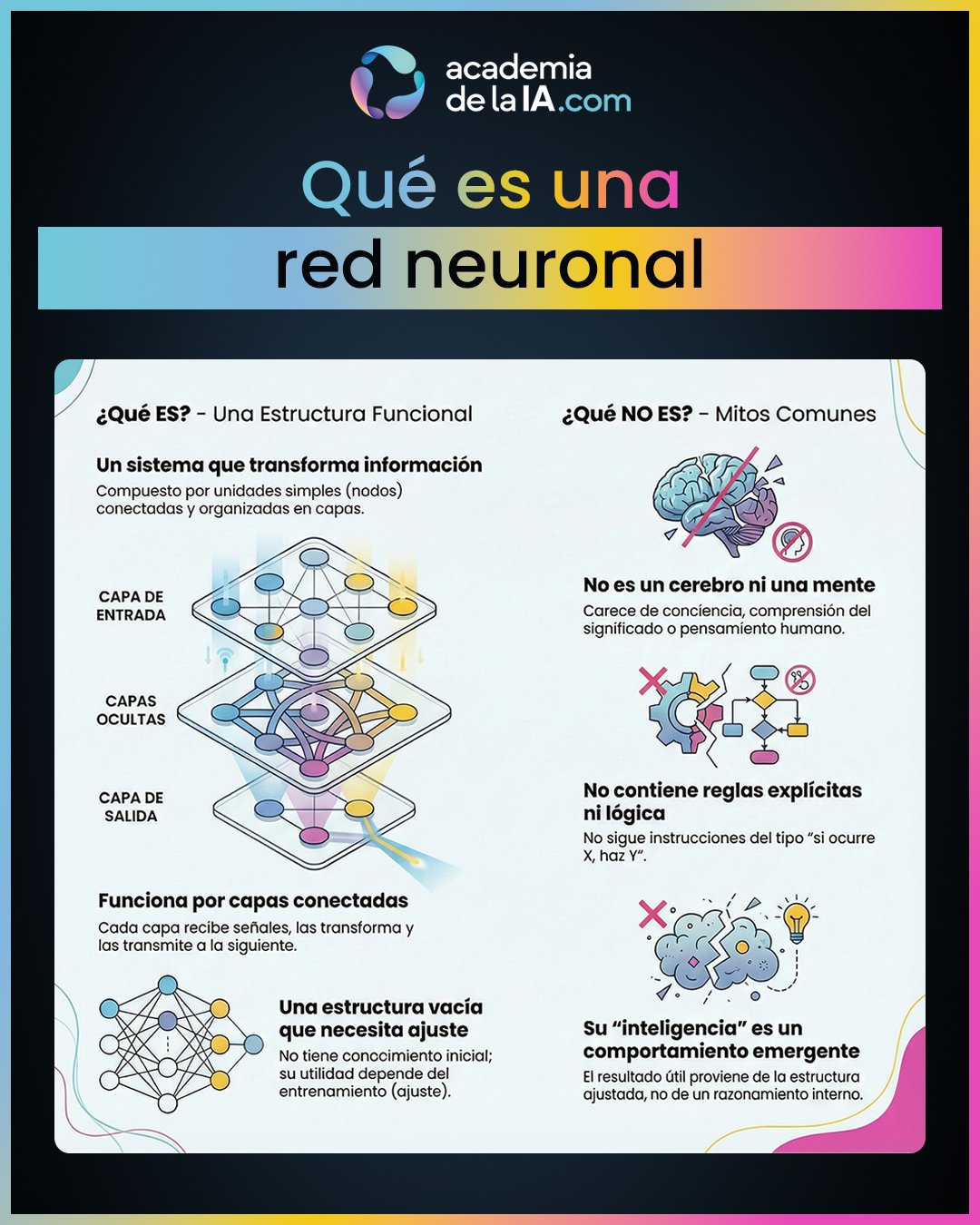

En este punto del curso damos un paso clave: dejamos de hablar de la IA como una idea general y empezamos a mirar qué estructura concreta hace posible su funcionamiento. La red neuronal artificial es el elemento central de la arquitectura de la IA moderna. No es un cerebro, no es una mente y no replica el pensamiento humano. Es una estructura técnica diseñada para transformar información.

Una red neuronal puede entenderse como un sistema compuesto por unidades simples conectadas entre sí, organizadas en capas. Cada una de estas unidades recibe señales, las transforma de forma elemental y las transmite a la siguiente capa. El resultado final es una salida que puede ser útil para una tarea concreta, aunque el sistema no “sepa” qué está haciendo en términos humanos.

Es importante entender que una red neuronal no contiene reglas escritas, ni lógica simbólica, ni razonamiento consciente. No hay decisiones deliberadas ni comprensión del significado. Todo su funcionamiento se basa en transformar señales de entrada en señales de salida a través de una estructura fija de conexiones. La inteligencia aparente no está en una mente interna, sino en el comportamiento global que emerge de esa estructura cuando se ajusta correctamente.

Este capítulo establece la base para todo lo que viene después. Antes de hablar de aprendizaje, entrenamiento o resultados, es imprescindible entender que una red neuronal es, en origen, una estructura vacía, sin conocimiento previo. Solo cuando esa estructura se ajusta mediante un proceso específico empieza a comportarse de forma útil.

Aprendizaje de este capítulo

- Una red neuronal artificial no es un cerebro ni una mente: es una estructura funcional diseñada para transformar información de entrada en una salida, sin comprensión ni conciencia.

- Su funcionamiento se basa en nodos simples conectados entre sí, organizados en capas, donde cada capa transforma la información recibida y la transmite a la siguiente.

- No existen reglas explícitas dentro de una red neuronal. No hay instrucciones del tipo “si ocurre X, haz Y”; solo hay transformación de señales a través de conexiones ajustables.

- La red, por sí sola, no sabe nada ni hace nada útil. Es una estructura preparada para ser ajustada, pero sin contenido ni conocimiento inicial.

- Comprender la red neuronal como estructura —y no como entidad inteligente— es clave para evitar errores posteriores al interpretar lo que la IA puede o no puede hacer.

CAPÍTULO 12

Cómo se entrena una red neuronal

Resumen del capítulo

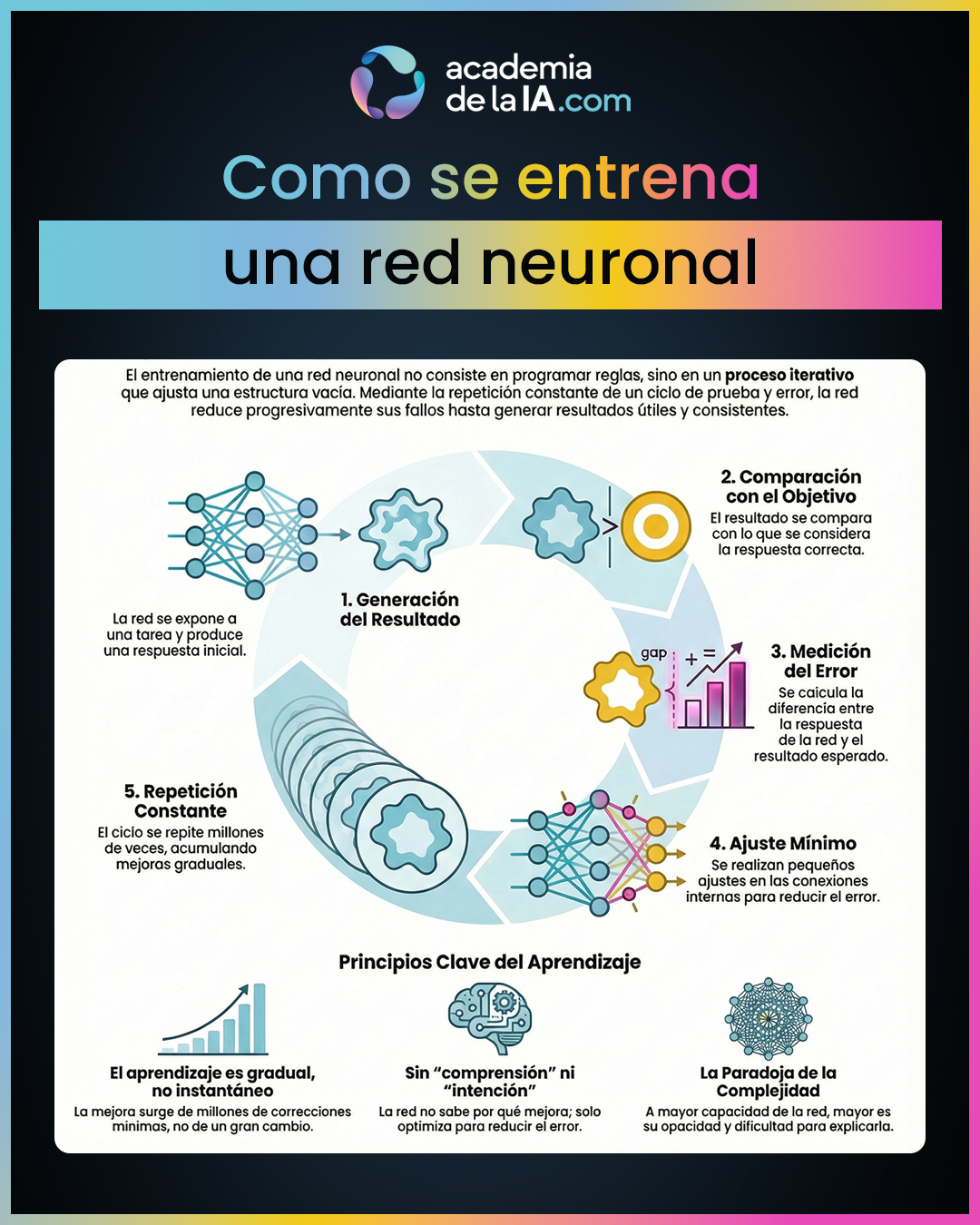

Una vez entendida la red neuronal como una estructura vacía, este capítulo explica el proceso que la convierte en algo funcional: el entrenamiento. Entrenar no es programar comportamientos ni introducir reglas nuevas, sino ajustar progresivamente una estructura existente hasta que produce resultados útiles.

El entrenamiento consiste en exponer la red a una tarea, observar qué resultado genera y comparar ese resultado con lo que se considera correcto o esperado. A partir de esa comparación se mide el error y se realizan pequeños ajustes en las conexiones internas. Este ciclo se repite una y otra vez, de forma iterativa, hasta que el rendimiento mejora de manera consistente.

Es clave entender que el aprendizaje no es instantáneo ni consciente. La red no “se da cuenta” de nada ni entiende por qué mejora. Simplemente va reduciendo el error paso a paso mediante ajustes muy pequeños acumulados en el tiempo. La mejora no surge de una sola decisión brillante, sino de millones de correcciones mínimas.

El capítulo también introduce una idea importante que acompañará al resto del bloque: cuanto más compleja es la red y más se ajusta, mayor capacidad puede alcanzar, pero también mayor opacidad. El mismo proceso que permite resultados muy potentes hace que sea cada vez más difícil explicar internamente por qué la red responde como responde.

Aprendizaje de este capítulo

- Entrenar una red neuronal no es programarla, sino ajustar progresivamente sus conexiones internas para que reduzca errores en una tarea concreta.

- El proceso de entrenamiento es iterativo: la red produce un resultado, se compara con el esperado, se mide el error y se ajusta ligeramente su estructura. Este ciclo se repite muchas veces.

- La primera respuesta de una red entrenándose suele ser mala. La mejora aparece de forma gradual, a través de acumulación de pequeños ajustes, no por cambios drásticos.

- Durante el entrenamiento no hay comprensión ni intención. La red no sabe por qué mejora ni qué significa hacerlo bien; simplemente optimiza su comportamiento respecto a un criterio externo.

- A mayor complejidad y capacidad de la red, mayor es también la opacidad interna: el sistema puede funcionar mejor, pero resulta más difícil entender cómo llega a sus resultados.

CAPÍTULO 13

Qué es el deep learning

Resumen del capítulo

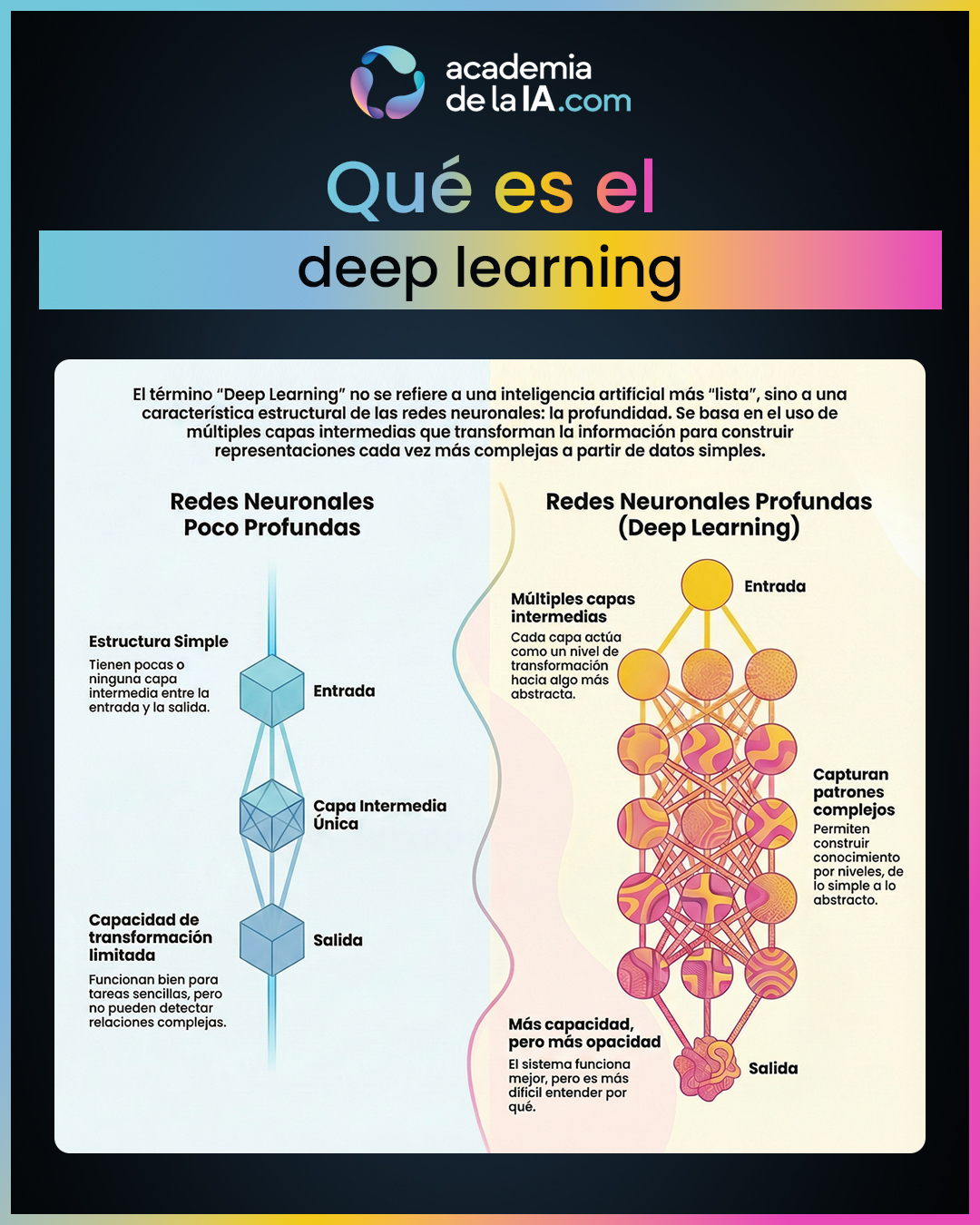

Después de entender qué es una red neuronal y cómo se entrena, este capítulo introduce un matiz clave: no todas las redes neuronales son iguales. La diferencia no está solo en el tamaño, sino en la profundidad de su estructura.

El término deep learning no se refiere a que una IA sea más “lista” o más cercana a la inteligencia humana, sino a que la red neuronal tiene más capas intermedias. Cada una de estas capas transforma la información que recibe, permitiendo que el sistema represente patrones cada vez más complejos a partir de otros más simples.

En redes poco profundas, la capacidad de transformación es limitada. Funcionan bien para tareas sencillas, pero se quedan cortas cuando el problema requiere detectar relaciones complejas, dependencias sutiles o estructuras jerárquicas. Las redes profundas, en cambio, permiten construir ese conocimiento por niveles: de lo simple a lo abstracto, paso a paso.

El capítulo deja claro que la profundidad no es una mejora gratuita. Aporta una gran capacidad de representación, pero también introduce nuevos retos: más dificultad para entender qué ocurre internamente, mayor dependencia del entrenamiento y un aumento de la complejidad del sistema. Deep learning no es magia ni marketing: es una consecuencia estructural de añadir capas.

Aprendizaje de este capítulo

- Deep learning significa redes neuronales con muchas capas, no una forma distinta de inteligencia ni un salto automático en calidad.

- Cada capa actúa como un nivel de transformación: toma lo que recibe y lo convierte en algo ligeramente más abstracto, permitiendo construir representaciones complejas a partir de señales simples.

- Las redes poco profundas tienen una capacidad limitada. Algunas tareas solo son posibles cuando existe profundidad suficiente para encadenar transformaciones.

- La profundidad permite capturar patrones complejos sin reglas explícitas, pero no implica comprensión ni razonamiento humano.

- Más capas significan más capacidad, pero también más complejidad y más opacidad: el sistema funciona mejor, pero es más difícil saber por qué.

CAPÍTULO 14

Por qué la profundidad cambia lo que la IA puede hacer

Resumen del capítulo

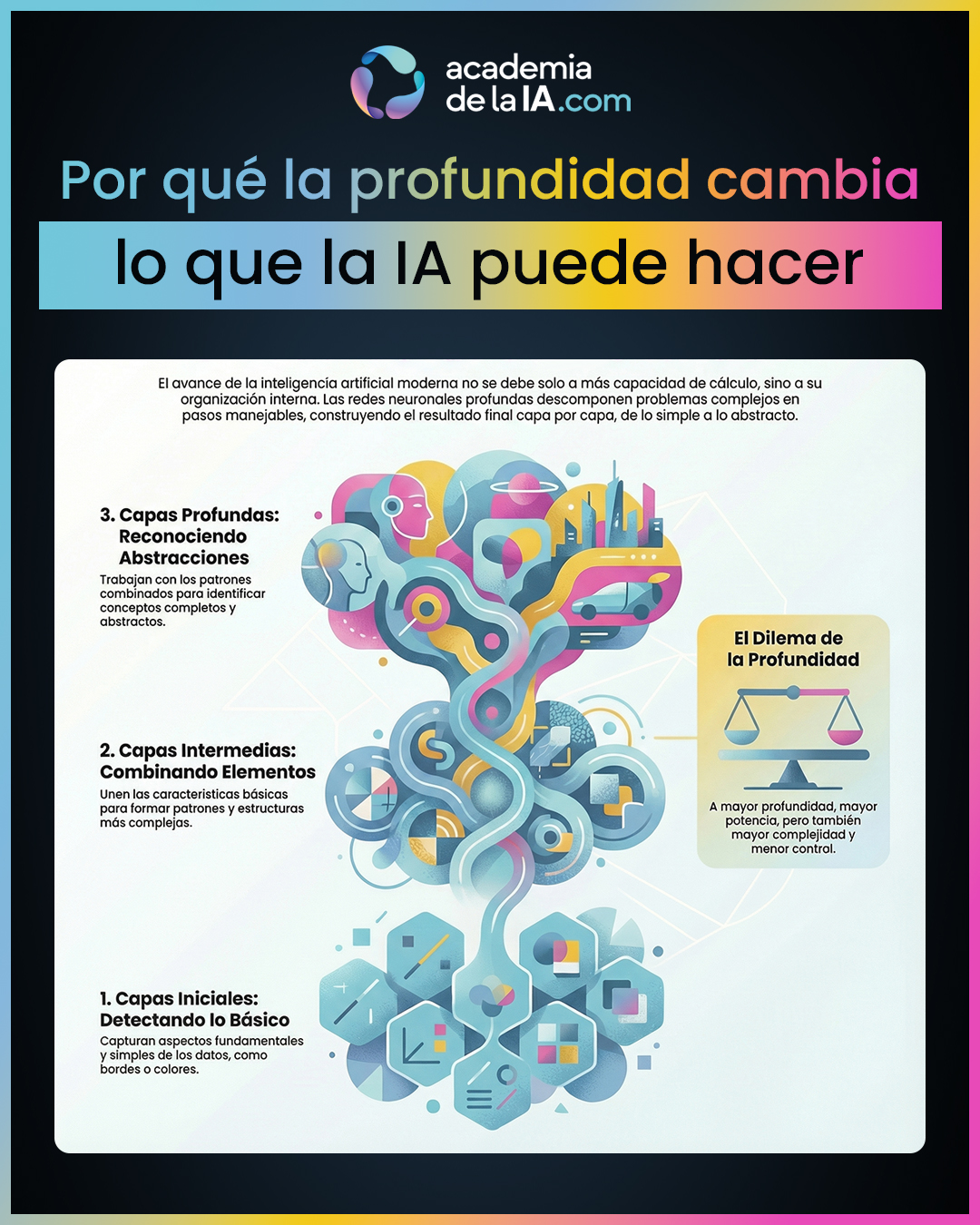

En el capítulo anterior vimos que el deep learning no consiste en “más inteligencia”, sino en más capas. En este capítulo damos un paso más y explicamos por qué esa profundidad cambia de forma real lo que una IA puede hacer.

La clave no está en la cantidad de cálculo ni en el tamaño del sistema, sino en su organización interna. Cada capa de una red profunda actúa como un filtro que transforma la información recibida, y lo hace sobre el resultado de las capas anteriores. Esto permite que el sistema construya representaciones progresivamente más complejas sin necesidad de reglas explícitas.

En lugar de enfrentarse al problema completo de una sola vez, la red lo descompone de forma implícita: las primeras capas capturan aspectos simples, las siguientes combinan esos elementos, y las capas más profundas trabajan con estructuras cada vez más abstractas. Esta organización jerárquica es lo que hace posible que la IA aborde tareas que serían inalcanzables para redes superficiales.

El capítulo subraya una idea importante: esta potencia no surge porque la IA “entienda” mejor, sino porque la profundidad permite que emerjan patrones complejos a partir de transformaciones sucesivas. Al mismo tiempo, se introduce una advertencia clara: cuanto más profunda es la red, mayor es su capacidad… pero también mayor es el coste en complejidad y control.

Aprendizaje de este capítulo

- La profundidad no es una cuestión de tamaño, sino de organización interna de la información dentro del sistema.

- Cada capa funciona como un filtro sucesivo que transforma lo recibido y lo entrega a la siguiente, permitiendo una construcción gradual del resultado.

- Las representaciones jerárquicas permiten pasar de señales simples a patrones complejos sin escribir reglas explícitas.

- La capacidad de la IA moderna emerge de esta combinación progresiva, no de un razonamiento consciente ni de comprensión humana.

- A mayor profundidad, mayor potencia… pero también mayor complejidad estructural, lo que prepara el terreno para hablar de límites y opacidad.

CAPÍTULO 15

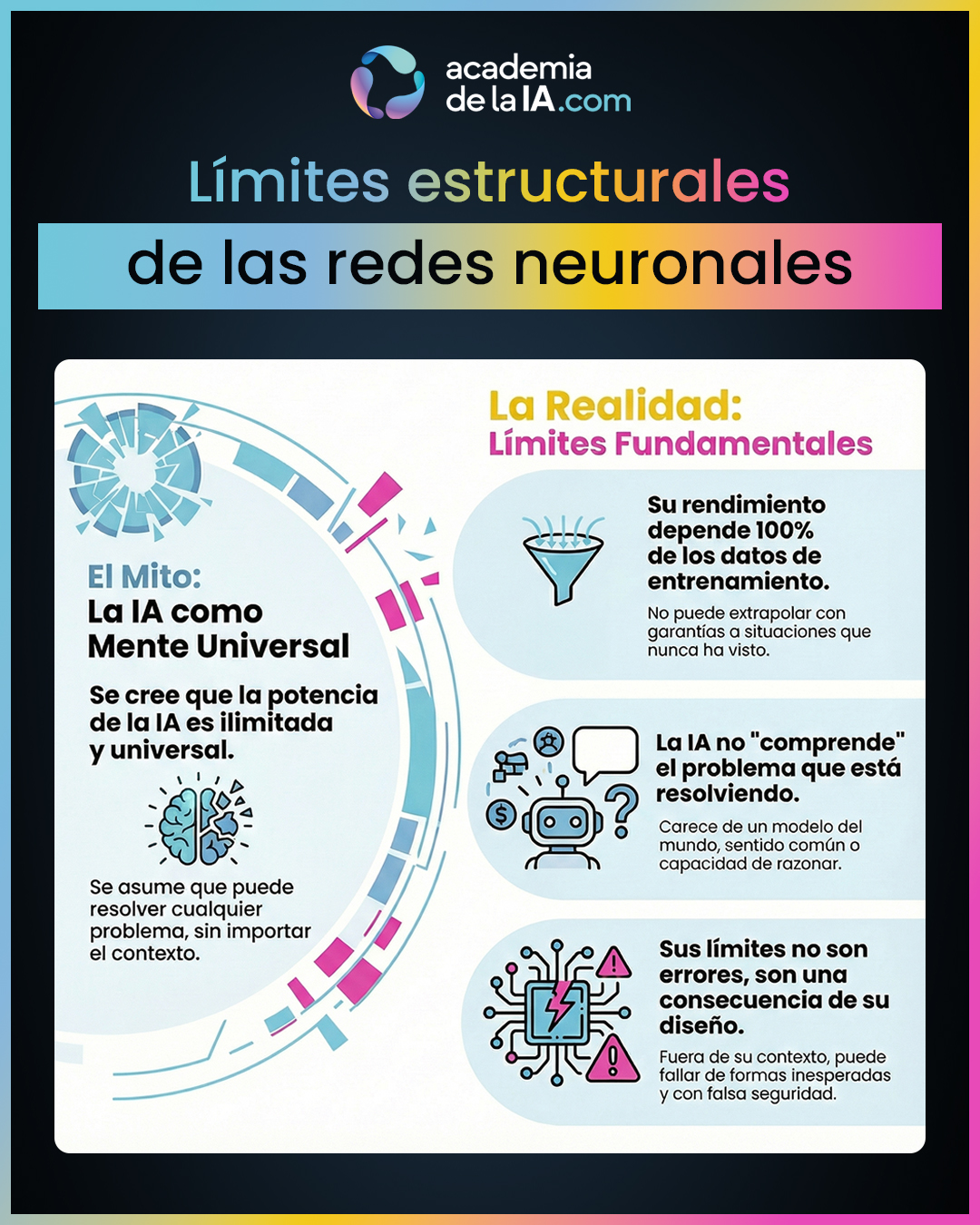

Límites estructurales de las redes neuronales

Resumen del capítulo

En los capítulos anteriores hemos visto por qué las redes profundas permiten a la IA realizar tareas complejas sin reglas explícitas. En este capítulo damos un paso imprescindible: entender que esa potencia no es ilimitada. La arquitectura que habilita capacidades también impone límites claros.

Una red neuronal no es un sistema universal ni una mente general. Su comportamiento depende completamente de los datos y situaciones que ha visto durante su ajuste. Cuando el contexto se mantiene dentro de lo aprendido, puede rendir muy bien; cuando se sale de ese marco, el sistema puede fallar de formas inesperadas, incluso cuando parece seguro de sí mismo.

El capítulo subraya una diferencia clave: la red no comprende el problema que resuelve. No tiene un modelo del mundo, ni sentido común, ni capacidad de reinterpretar una situación nueva desde principios generales. Su “inteligencia” es local y contextual, no global.

Estos límites no son errores de implementación ni defectos corregibles con más potencia sin más. Son consecuencias directas de la arquitectura: depender de datos pasados implica fragilidad ante lo no visto. Este cierre prepara el terreno para entender por qué, a pesar de su alto rendimiento, muchas decisiones internas de la IA resultan opacas para los humanos.

Aprendizaje de este capítulo

- Que una red neuronal sea potente no significa que sea universal: funciona bien dentro de su contexto aprendido, no fuera de él.

- Su comportamiento depende totalmente de los datos con los que se ha ajustado; no puede extrapolar con garantías a mundos que no ha visto.

- La red puede producir respuestas correctas sin comprender lo que hace ni por qué lo hace.

- Fuera de su dominio, la IA puede mostrar fragilidad, errores inesperados o falsas seguridades.

- Estos límites no son accidentales: son una consecuencia directa de cómo está construida la arquitectura.

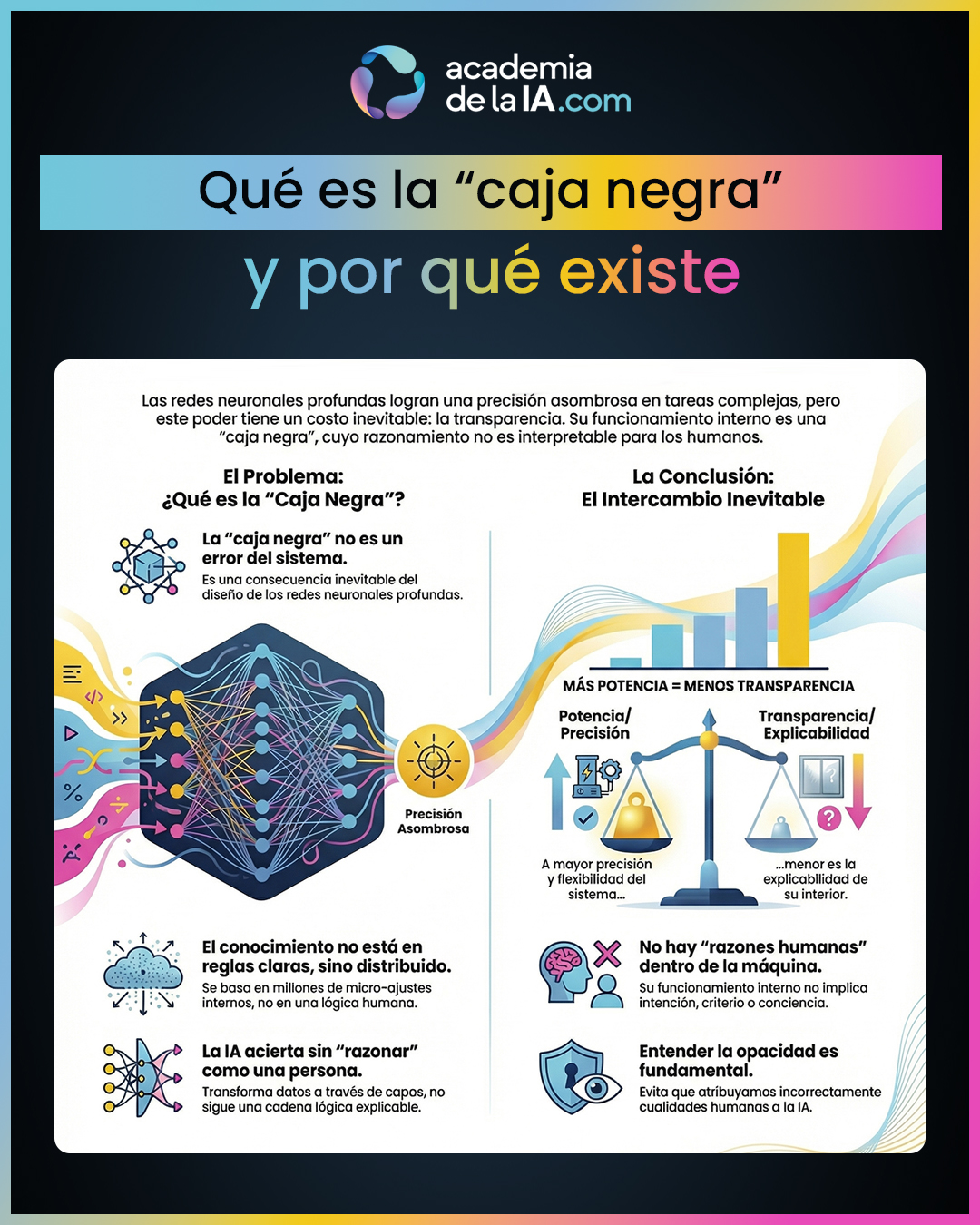

CAPÍTULO 16

Qué es la “caja negra” y por qué existe

Resumen del capítulo

Después de entender cómo se construyen y entrenan las redes neuronales, llegamos a una consecuencia inevitable de esa arquitectura: la opacidad. Este capítulo explica por qué muchas IAs modernas funcionan como una caja negra, no como un fallo del sistema, sino como el resultado directo de su diseño.

En sistemas simples, donde las reglas son explícitas y pocas, es posible seguir el razonamiento paso a paso. En redes profundas, sin embargo, el conocimiento no está almacenado en reglas comprensibles, sino distribuido en millones de pequeños ajustes internos. El sistema no “razona” como una persona ni sigue una cadena lógica interpretable: transforma información a través de múltiples capas hasta producir un resultado.

Este diseño permite una precisión muy alta en tareas complejas, pero introduce un intercambio inevitable: cuanto más potente y flexible es el sistema, menos transparente resulta su funcionamiento interno. No hay razones humanas dentro de la máquina, solo estados internos que conducen a una salida correcta.

El capítulo cierra el bloque dejando claro que la caja negra no es misterio ni magia, sino el precio arquitectónico que pagamos por la potencia de las redes profundas. Este entendimiento es clave antes de avanzar hacia cómo estas arquitecturas empiezan a manejar algo especialmente sensible: el lenguaje.

Aprendizaje de este capítulo

- La caja negra no es un error ni una falta de diseño, sino una consecuencia directa de cómo funcionan las redes neuronales profundas.

- En sistemas complejos, el conocimiento no está en reglas claras, sino distribuido en millones de pequeños ajustes internos.

- La IA puede acertar sin poder explicar su razonamiento en términos humanos, porque no opera con lógica explícita.

- Existe un intercambio estructural entre precisión y explicabilidad: más potencia implica menos transparencia.

- Entender esta opacidad es esencial para no atribuir intención, criterio o razonamiento humano a la IA.

¿Listo para el siguiente paso?

El conocimiento se construye capa por capa.

Continúa tu recorrido por los siguientes bloques, donde profundizarás en cómo funciona la IA, aprenderás a comunicarte con ella y desarrollarás criterio para un uso responsable.