Curso IA

Bloque 7 · Límites y futuro

Hasta dónde llega la IA y qué no debemos delegar nunca

El Bloque 7 cierra el curso con una mirada sobria, responsable y no ingenua sobre la inteligencia artificial. Después de haber entendido cómo funciona, cómo interactuar con ella y cómo usarla con criterio, este bloque responde a la pregunta clave que queda siempre en el aire: ¿hasta dónde llega la IA… y dónde debe parar?

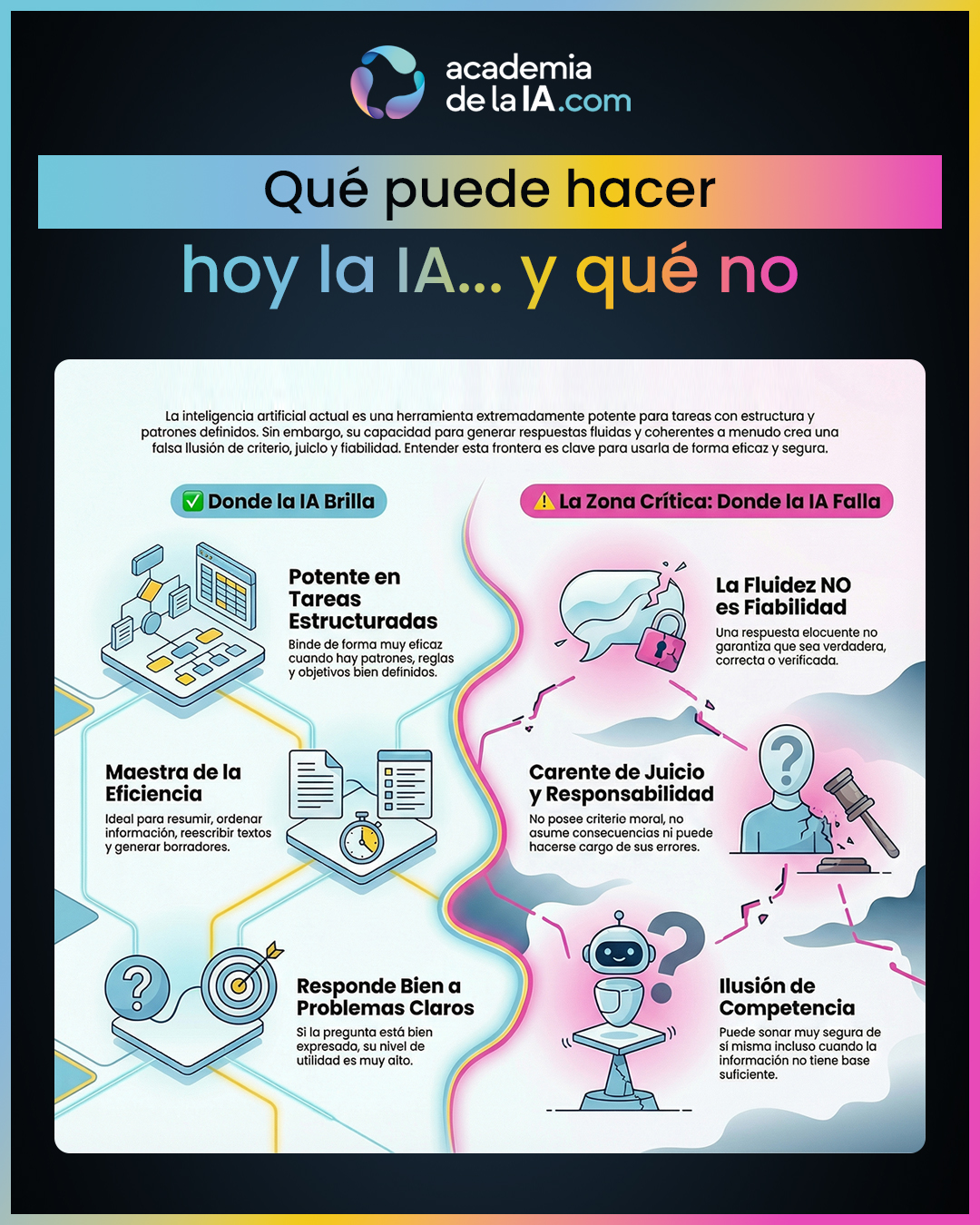

El primer objetivo del bloque es aterrizar expectativas. Se desmontan dos extremos habituales: la idealización (“la IA puede con todo”) y el rechazo (“no es fiable para nada”). El alumno aprende a distinguir entre capacidades reales, limitaciones estructurales e ilusiones de competencia. La IA actual puede rendir muy bien en tareas con estructura, patrones y lenguaje claro, pero es frágil cuando entra en juego el juicio, la verificación profunda, la responsabilidad o las consecuencias humanas. Aquí se fija una idea central que atraviesa todo el bloque: fluidez no equivale a fiabilidad, y rendimiento no equivale a criterio.

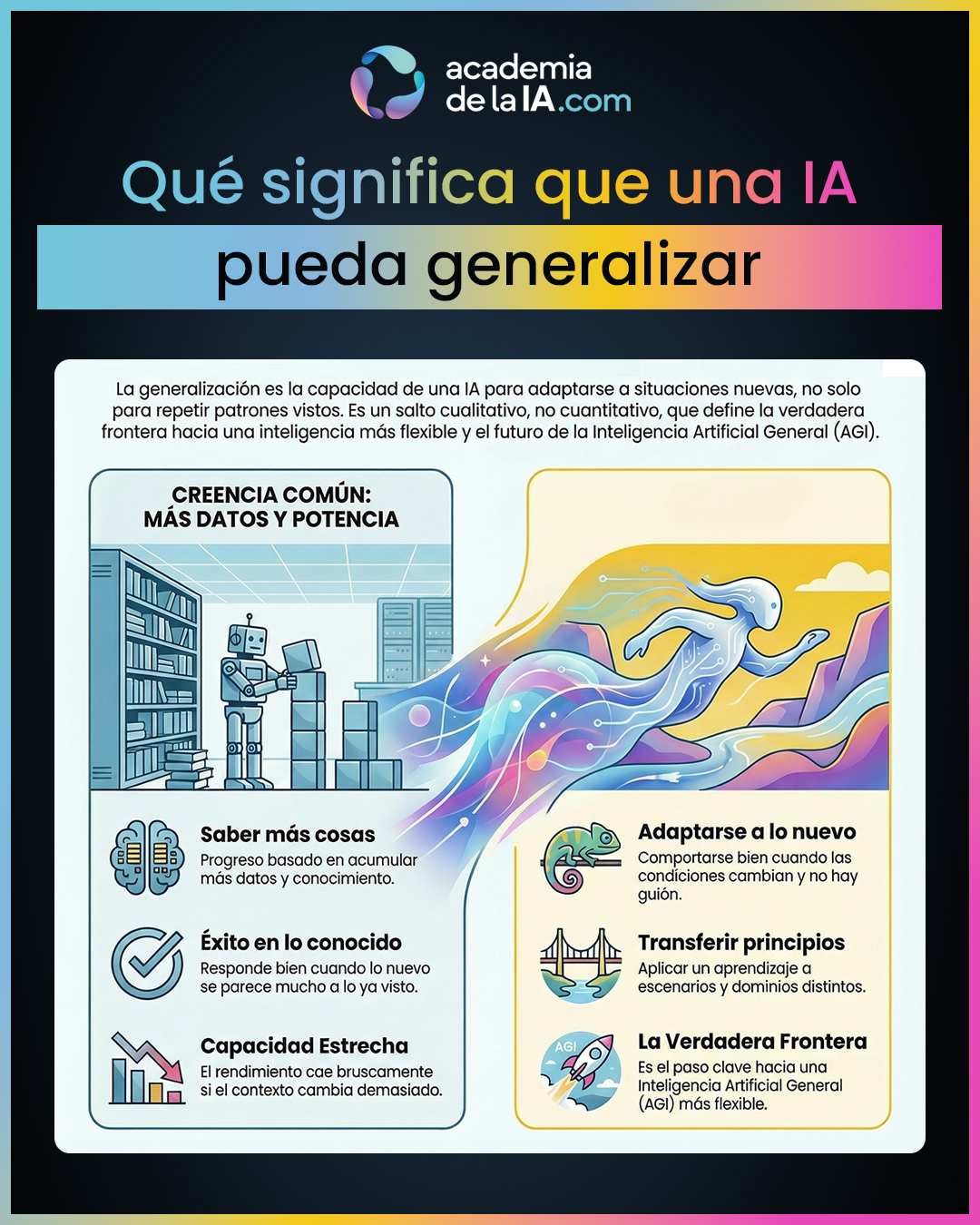

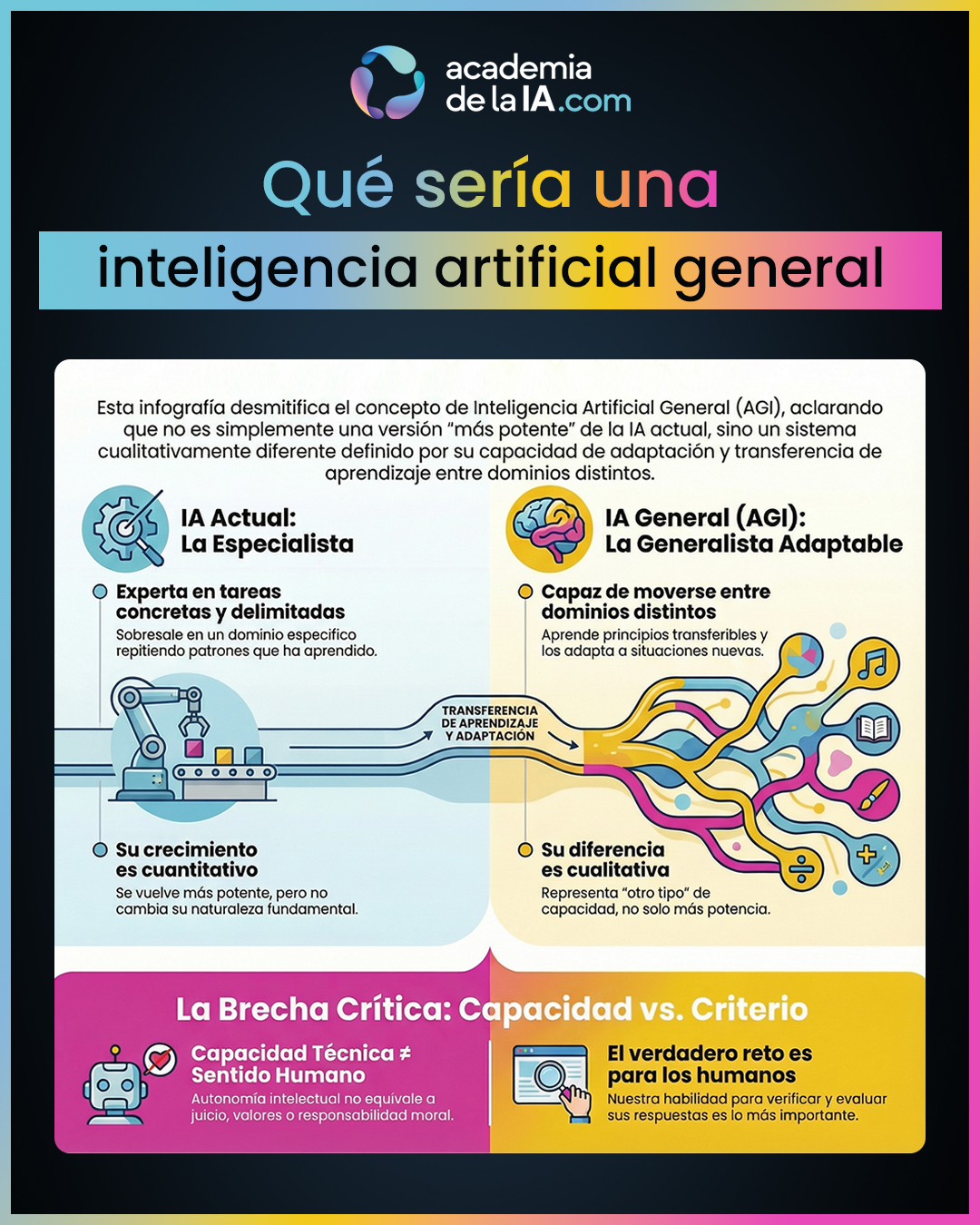

A partir de ahí, el bloque introduce con rigor el concepto que marca el futuro real de la IA: la generalización. No como “saber más cosas”, sino como la capacidad de comportarse bien cuando el contexto cambia y no hay guión. Se explica por qué este salto es cualitativo y por qué sigue siendo una frontera difícil para las máquinas. Este concepto sirve de puente para definir qué sería una inteligencia artificial general (AGI), evitando tanto la fantasía como el alarmismo: una AGI no sería “una IA más potente”, sino una IA más flexible entre dominios, pero ni siquiera eso implicaría responsabilidad, valores o juicio moral.

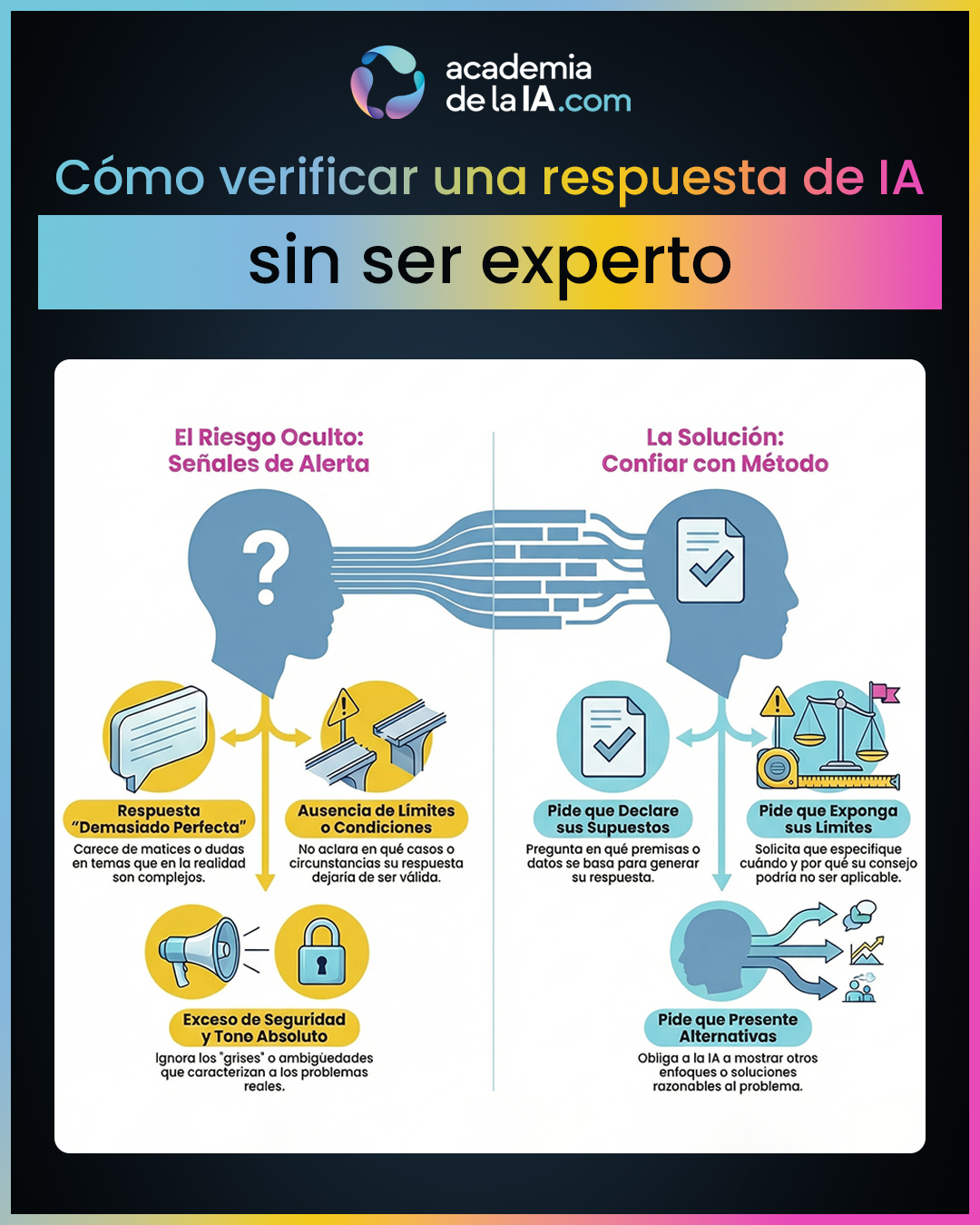

Con este marco claro, el bloque baja de nuevo a lo práctico y aborda uno de los riesgos más reales del uso cotidiano de la IA: equivocarse con apariencia de seguridad. El alumno aprende a verificar respuestas sin necesidad de ser experto, desarrollando un método mental basado en exigir límites, condiciones, supuestos y alternativas. No se trata de desconfiar de todo, sino de confiar con método, entendiendo que el criterio humano sigue siendo imprescindible.

El punto culminante del bloque es la definición explícita de una línea roja de delegación. Se establece con claridad la diferencia entre apoyar una decisión y sustituir el juicio humano. La IA puede analizar, sugerir y ordenar, pero no puede asumir consecuencias. Cuanto más irreversible y humano es el impacto de una decisión, menos delegable es. La responsabilidad no se automatiza.

El bloque se cierra con una reflexión final sobre qué relación sana deberíamos construir con la IA. Lejos de discursos épicos o catastrofistas, la conclusión es clara: la IA es una herramienta que amplifica lo que somos. Puede multiplicar claridad o confusión, criterio o negligencia. El progreso real no está en “más IA”, sino en mejor criterio humano al usarla.

CAPÍTULO 37

Qué puede hacer hoy la IA… y qué no

Resumen del capítulo

Este capítulo aterriza expectativas y pone orden en una confusión muy extendida: confundir la capacidad de respuesta de la IA con criterio real. Tras comprender cómo funciona la IA y cómo interactuamos con ella, aquí se construye un mapa claro de lo que la IA actual hace bien, de dónde suele fallar y de qué cosas no puede hacer aunque a veces lo parezca.

Se explica que la IA es especialmente potente en tareas donde hay estructura, patrones y objetivos bien definidos. Resumir, ordenar información, reescribir textos, generar borradores, comparar opciones o traducir ideas a estructuras claras son ámbitos donde suele rendir de forma muy eficaz. Cuando el problema está bien expresado, la IA responde con alto nivel de utilidad, no porque “entienda”, sino porque ha aprendido patrones de lenguaje y conocimiento que funcionan en esos contextos.

El capítulo introduce después la zona crítica: aquellas situaciones donde la IA empieza a fallar. Cuando el reto no es responder, sino acertar con fundamento; cuando hace falta verificar hechos de forma fiable; cuando hay ambigüedad moral, consecuencias humanas o necesidad de asumir responsabilidad, la IA se vuelve frágil. Puede construir respuestas coherentes incluso sin base suficiente y, lo más peligroso, puede sonar segura cuando no lo está. Aquí se fija una idea clave que atraviesa todo el bloque: la fluidez no es fiabilidad.

A continuación, se aclara qué cosas la IA no puede hacer, aunque su forma de expresarse lleve a pensarlo. No tiene juicio humano, no asume responsabilidad, no posee criterio moral ni puede hacerse cargo del daño si se equivoca. La ilusión aparece porque hablamos con algo que se expresa bien, y tendemos a proyectar intención, sensatez y criterio donde solo hay generación de lenguaje optimizada.

El cierre consolida la idea central del capítulo: la potencia de la IA es real, pero su frontera también lo es. Entender esa frontera no es ser pesimista ni tecnófobo, sino desarrollar criterio. Este mapa de capacidades y límites prepara el terreno para hablar del futuro con rigor, introduciendo la noción de generalización como el verdadero salto pendiente.

Aprendizaje de este capítulo

- La IA actual es muy potente en tareas donde hay estructura, patrones y objetivos bien definidos.

- Un alto rendimiento en una tarea concreta no equivale a tener criterio o juicio real.

- La fluidez del lenguaje no es una garantía de fiabilidad ni de verdad.

- La IA suele fallar cuando lo importante no es responder, sino acertar con fundamento.

- Es especialmente frágil cuando se requieren verificación fiable, juicio humano o responsabilidad.

- Puede generar respuestas coherentes incluso sin base suficiente, sonando segura aunque no lo esté.

- La forma convincente de expresarse genera una ilusión de competencia que puede inducir a error.

- La IA no tiene juicio humano, no asume consecuencias y no posee criterio moral.

- Entender los límites reales de la IA no es ser pesimista, sino desarrollar criterio de uso.

- Distinguir entre capacidad técnica y responsabilidad humana es clave para hablar del futuro con rigor.

CAPÍTULO 38

Qué significa que una IA pueda generalizar

Resumen del capítulo

Este capítulo introduce una de las ideas más importantes para entender el futuro real de la inteligencia artificial: la generalización. Frente a la intuición común de que el progreso de la IA consiste simplemente en tener más datos, más potencia o más velocidad, aquí se aclara que el salto verdaderamente relevante es cualitativo, no cuantitativo. Generalizar no es saber más cosas, sino comportarse bien cuando las condiciones cambian y no existe un guión previo.

Se define la generalización como la capacidad de afrontar situaciones nuevas con coherencia. No se trata de repetir patrones aprendidos en contextos muy similares, sino de transferir principios a escenarios distintos. El capítulo establece una distinción clave: responder bien cuando lo nuevo se parece mucho a lo visto no es generalizar; generalizar es mantener el rendimiento cuando lo nuevo cambia de forma, pero conserva un principio subyacente.

Para hacerlo comprensible, se compara este proceso con el aprendizaje humano, sin idealizarlo. Las personas somos capaces de trasladar aprendizajes entre dominios distintos: entendemos una regla o un principio y lo aplicamos en otro contexto. No lo hacemos de forma perfecta, pero sí con una flexibilidad natural que hoy sigue siendo difícil de replicar en máquinas.

El capítulo explica por qué esta flexibilidad cuesta tanto en sistemas artificiales, sin entrar en tecnicismos. Las IA tienden a depender del tipo de casos que han visto durante su entrenamiento. Cuando el contexto cambia demasiado respecto a esos casos, el rendimiento puede caer de forma brusca. Esto muestra que muchas capacidades actuales son estrechas: funcionan muy bien dentro de su terreno, pero se degradan fuera de él.

El cierre refuerza la idea de que la generalización es el verdadero salto pendiente, porque implica adaptabilidad real. Cuando una IA logra generalizar de verdad, deja de estar limitada a un conjunto cerrado de situaciones. Esa posibilidad abre la puerta al siguiente concepto del curso: qué se entiende por una inteligencia artificial general, o AGI, como nombre de ese salto llevado al extremo.

Aprendizaje de este capítulo

- Generalizar no significa tener más datos ni más conocimiento acumulado, sino mantener el rendimiento cuando el contexto cambia.

- La generalización es una capacidad cualitativa: adaptarse bien cuando no hay plantilla ni ejemplo previo.

- Responder correctamente a casos similares no es generalizar; generalizar implica transferir principios a situaciones nuevas.

- La IA actual suele rendir bien dentro de su terreno, pero su rendimiento puede caer cuando el contexto cambia mucho.

- Los humanos generalizan trasladando principios entre dominios, aunque no lo hagan de forma perfecta.

- Las máquinas tienden a depender de los tipos de casos que han visto, lo que limita su flexibilidad.

- La generalización es la frontera real entre la IA actual y una IA más flexible.

- Entender la generalización es clave para hablar con rigor del futuro de la IA y del concepto de AGI.

CAPÍTULO 39

Qué sería una inteligencia artificial general

Resumen del capítulo

Este capítulo pone orden en uno de los conceptos más confusos y sobrecargados del discurso sobre inteligencia artificial: la AGI. Lejos de la ciencia ficción, las promesas grandilocuentes o las visiones apocalípticas, aquí se define la inteligencia artificial general con rigor y sobriedad, como algo cualitativamente distinto de la IA actual, no simplemente como una versión “más potente”.

La idea central es que una AGI no se caracterizaría por hacer mejor lo que ya hacen las IA actuales, sino por poder moverse entre tareas y dominios distintos manteniendo coherencia. Mientras que la IA actual destaca en tareas concretas y bien delimitadas, una AGI sería capaz de aprender principios transferibles y adaptarlos a situaciones nuevas, incluso cuando cambian las reglas del juego.

Para clarificar esta diferencia, el capítulo insiste en que se trata de “otro tipo” de capacidad. No solo saber hacer cosas, sino saber adaptarse. No solo repetir patrones aprendidos, sino aprender de forma más flexible. El ejemplo del aprendiz que puede aprender oficios distintos usando un mismo método sirve para ilustrar esta idea sin recurrir a metáforas exageradas.

Se introduce también el concepto de autonomía intelectual, entendida como la capacidad de planificar, aprender y abordar tareas nuevas con menos guía externa. Pero aquí aparece uno de los matices más importantes de todo el curso: esa autonomía intelectual no implica juicio humano. El capítulo subraya de forma explícita que una AGI no tendría responsabilidad, valores ni criterio moral por el simple hecho de ser más capaz técnicamente.

La frase clave que atraviesa el capítulo es clara: capacidad técnica no equivale a sentido humano. Incluso en el escenario hipotético de una AGI funcional, seguiría existiendo algo que no es técnico ni automatizable: el criterio. Por eso, el cierre desplaza el foco desde la fantasía tecnológica hacia una cuestión mucho más práctica y relevante: la necesidad de que los humanos sepamos verificar, evaluar y asumir responsabilidad.

Este planteamiento prepara el terreno para el siguiente capítulo, donde el protagonismo ya no está en lo que la IA podría llegar a ser, sino en una habilidad humana imprescindible: saber comprobar y validar sus respuestas.

Aprendizaje de este capítulo

- AGI no significa una IA más potente, sino una IA de otro tipo, basada en generalización amplia entre dominios.

- Una AGI se definiría por su capacidad de adaptarse a tareas nuevas, no solo por ejecutar bien tareas concretas.

- La diferencia clave entre IA actual y AGI es cualitativa, no cuantitativa.

- Generalizar implica transferir principios, no repetir patrones aprendidos.

- La autonomía intelectual no equivale a juicio humano, valores ni responsabilidad.

- Una AGI, aunque existiera, no tendría criterio moral ni asumiría consecuencias.

- Capacidad técnica y sentido humano no son lo mismo y no deben confundirse.

- El verdadero reto no es que la IA hable mejor, sino que los humanos sepamos verificar mejor sus respuestas.

CAPÍTULO 40

Cómo verificar una respuesta de IA sin ser experto

Resumen del capítulo

Este capítulo aborda uno de los riesgos más reales y frecuentes en el uso cotidiano de la inteligencia artificial: no que se equivoque, sino que se equivoque con apariencia de seguridad. La IA puede producir respuestas fluidas, bien redactadas y convincentes incluso cuando no están correctamente fundamentadas. Por eso, el problema principal no es el error en sí, sino no detectarlo.

El enfoque del capítulo no es fomentar la desconfianza permanente, sino instalar una actitud mucho más útil: confiar con método. Verificar no exige ser especialista en el tema ni tener conocimientos técnicos profundos. Exige, sobre todo, saber identificar señales de alerta y pedir estructura de validación. La idea central se resume en una frase clave: la fluidez no es fiabilidad.

Se explican tres señales habituales de riesgo. La primera es la respuesta “demasiado perfecta”: cerrada, sin matices ni dudas, en temas que en la realidad suelen ser complejos. La segunda es la ausencia de límites o condiciones: cuando una respuesta no aclara en qué casos dejaría de ser válida, conviene sospechar. La tercera es el exceso de seguridad, ese tono absoluto que ignora los grises que caracterizan a la mayoría de problemas reales.

El capítulo subraya que la realidad compleja casi siempre necesita condiciones. Cuando una respuesta no las menciona, no es necesariamente falsa, pero sí insuficientemente verificada. A partir de ahí, se introduce una idea clave: incluso sin saber del tema, el usuario puede exigir estructura de comprobación.

Se explican varias formas conceptuales de forzar esa verificación sin convertir la interacción en un tutorial técnico. Pedir que la IA declare sus supuestos, que marque límites de validez, que exponga alternativas razonables o que indique qué puntos concretos habría que comprobar son maneras eficaces de evaluar la solidez de una respuesta. No se trata de “pillar” a la IA, sino de obligarla a mostrar el andamiaje de su respuesta.

El cierre refuerza el mensaje central del curso: el criterio humano no se automatiza. La verificación es una habilidad que se puede aprender y entrenar, y es una pieza clave para usar la IA con responsabilidad. Este capítulo prepara directamente el terreno para el siguiente, donde se aborda una cuestión aún más decisiva: qué cosas, precisamente por esa falta de criterio automático, no deberíamos delegar nunca en una IA.

Aprendizaje de este capítulo

- El mayor riesgo no es que la IA falle, sino no notar que ha fallado.

- La fluidez del lenguaje no garantiza fiabilidad ni veracidad.

- Una respuesta fiable suele reconocer límites, condiciones y supuestos.

- Las respuestas excesivamente seguras o cerradas son una señal de alerta en temas complejos.

- La ausencia de condiciones o excepciones es un motivo razonable para sospechar.

- Verificar no exige ser experto: exige pedir estructura de validación.

- Pedir supuestos, límites, alternativas o puntos de comprobación mejora la fiabilidad percibida.

- Confiar con método es distinto de desconfiar siempre.

- El criterio humano no se puede automatizar ni delegar por completo.

CAPÍTULO 41

Qué no deberíamos delegar nunca a una IA

Resumen del capítulo

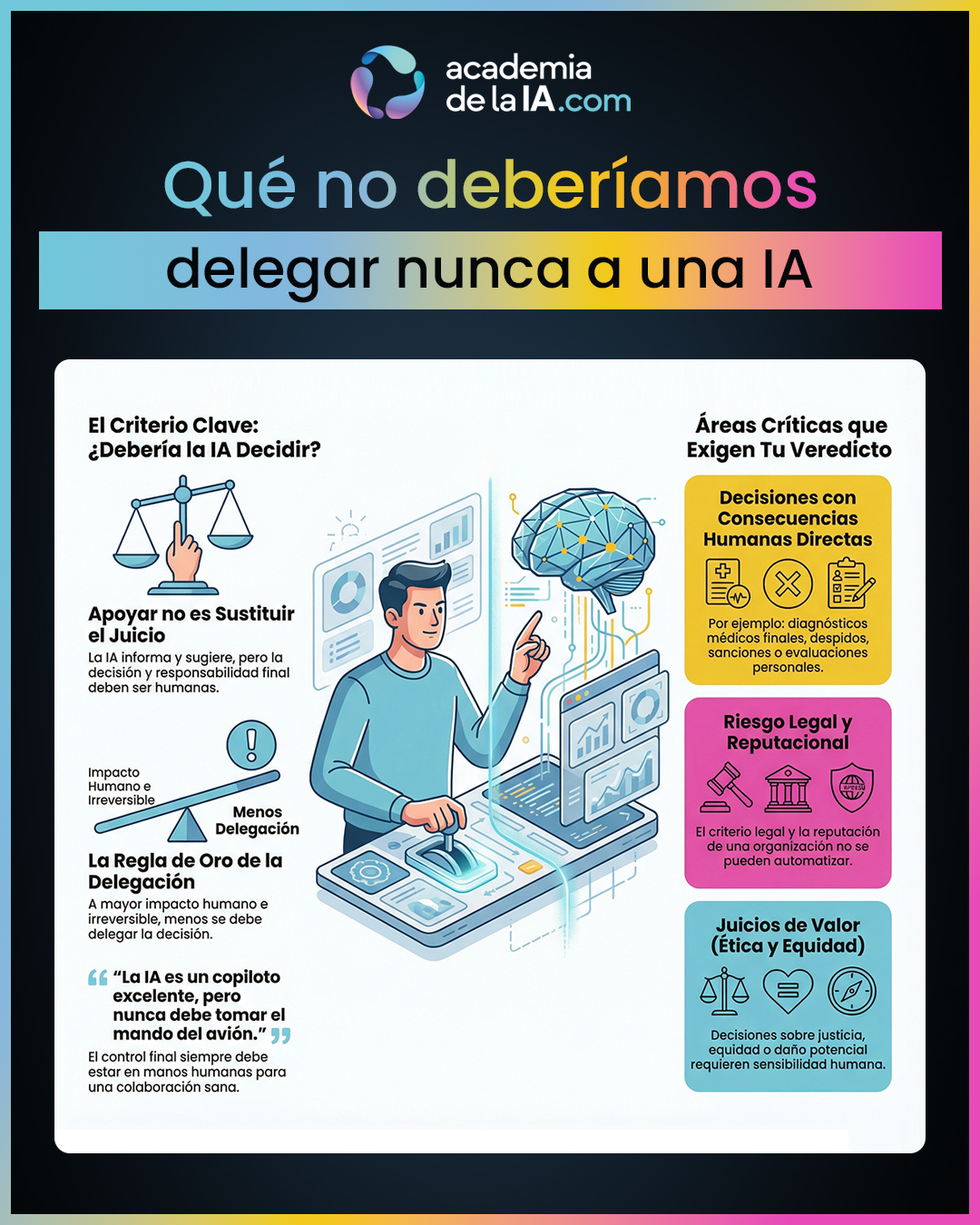

Este capítulo marca una de las líneas más importantes de todo el curso: la frontera entre usar la IA como apoyo y delegar en ella decisiones que implican responsabilidad humana. No es un capítulo moralista ni alarmista, sino profundamente operativo. Parte de una idea clave que ordena todo lo anterior: la IA puede ayudar mucho, pero no puede asumir consecuencias.

Se aclara desde el inicio que el problema no es usar IA, sino dejar que decida sola. Delegar sin supervisión crea un vacío de responsabilidad: si algo sale mal, nadie “responde” realmente por el daño. La IA no asume consecuencias legales, morales ni humanas. Esa carga sigue recayendo siempre en una persona o en una organización.

El capítulo establece una distinción fundamental que sirve como criterio general: no es lo mismo apoyar una decisión que sustituir el juicio humano. Apoyar significa informar, analizar, comparar y sugerir. Sustituir el juicio significa decidir, cerrar y ejecutar sin responsabilidad humana directa. Esa diferencia, aunque sutil en apariencia, cambia por completo el riesgo.

Se introduce entonces un criterio base muy potente: cuanto más irreversible y humano es el impacto de una decisión, menos delegable es. No importa lo bien que “razone” la IA ni lo convincente que suene. Si el impacto no se puede deshacer o afecta directamente a personas reales, la última palabra debe ser humana.

El capítulo recorre varias categorías de decisiones que no deberían delegarse por completo, explicadas con sentido y sin convertirlas en una lista fría. Decisiones con impacto irreversible, con consecuencias humanas directas, con riesgo legal o reputacional, o que implican juicios de valor como justicia o equidad, requieren siempre supervisión y decisión humana final. La IA puede aportar información valiosa en todos esos casos, pero no cerrar la decisión.

Los ejemplos que se mencionan —diagnósticos finales, decisiones legales, despidos, sanciones, adjudicación de oportunidades o evaluaciones personales— no buscan ser exhaustivos, sino servir como anclaje mental. Son situaciones donde una decisión errónea no es solo un fallo técnico, sino un daño real.

El cierre refuerza la idea central con una metáfora clara: la IA puede ser un copiloto excelente, pero nunca debe tomar el mando del avión. Saber qué no delegar es lo que permite, a partir de ahí, construir una relación sana, consciente y responsable con la IA, tema que se desarrolla en el último capítulo del curso.

Aprendizaje de este capítulo

- La pregunta clave no es si la IA puede hacerlo, sino si debería decidirlo ella.

- La IA puede ayudar, pero no puede asumir consecuencias humanas, legales o morales.

- Delegar sin supervisión crea un vacío de responsabilidad.

- Apoyar una decisión no es lo mismo que sustituir el juicio humano.

- La IA puede informar, analizar y sugerir, pero no debería cerrar decisiones críticas.

- Cuanto más irreversible y humano es el impacto, menos delegable es la decisión.

- Las decisiones con consecuencias humanas directas requieren siempre última palabra humana.

- El riesgo legal y reputacional no se puede automatizar.

- El juicio de valor (justicia, equidad, daño potencial) no es delegable a una IA.

- Usar IA con criterio implica saber tanto qué delegar como qué no delegar nunca.

CAPÍTULO 42

Qué relación deberíamos construir con la IA

Resumen del capítulo

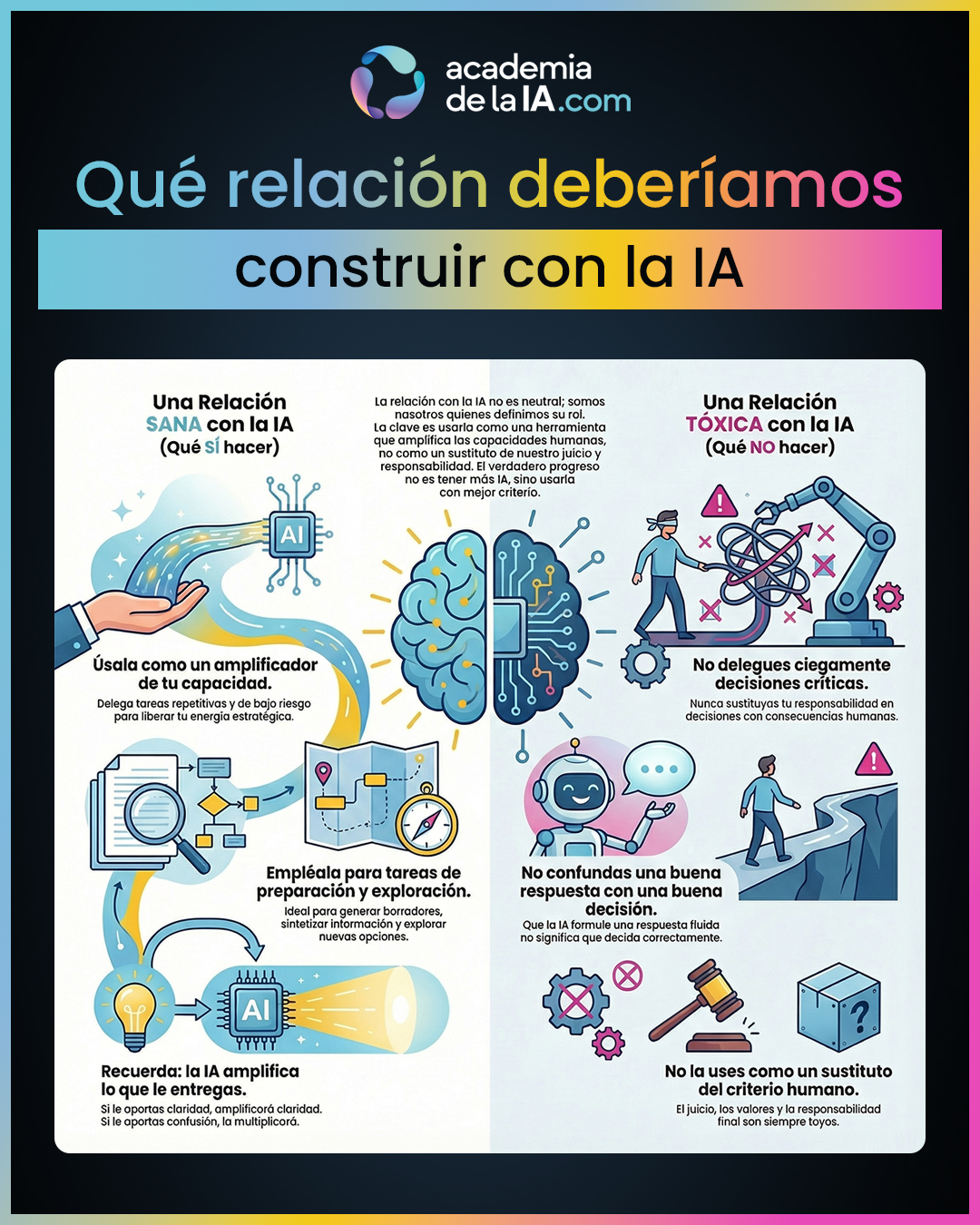

Este capítulo cierra el curso desplazando deliberadamente la pregunta del terreno técnico al terreno humano. Después de entender cómo funciona la IA, cómo interactuamos con ella, dónde falla y qué no debemos delegar nunca, la cuestión final ya no es qué puede hacer la IA, sino qué papel decidimos darle en nuestra vida y en nuestro trabajo.

Desde el inicio se establece una idea fundamental: la IA no decide sola su lugar. Somos nosotros quienes definimos la relación. No existe una relación “neutral” con la IA; toda forma de uso implica una elección consciente o inconsciente sobre cuánto delegamos, cuánto supervisamos y dónde ponemos el límite del criterio humano.

El capítulo define con claridad qué incluye una relación sana con la IA. No se habla de técnicas ni de trucos, sino de enfoque. Una relación sana implica delegar tareas repetitivas y de bajo riesgo, usar la IA para generar borradores, ordenar ideas, sintetizar información y explorar opciones. En este marco, la IA actúa como amplificador de productividad y claridad, no como sustituto del pensamiento.

Se introduce un matiz clave que rompe uno de los miedos habituales: usar bien la IA no te hace menos capaz. Al contrario, te vuelve más estratégico. Liberar tiempo y energía de tareas mecánicas permite concentrar el esfuerzo humano donde realmente importa el juicio, la responsabilidad y la toma de decisiones.

A continuación, el capítulo define con la misma claridad lo que una relación sana no incluye. No incluye la delegación ciega de decisiones con consecuencias humanas, ni el uso de la IA como sustituto de criterio, valores o responsabilidad. Tampoco incluye confundir una respuesta bien formulada con una decisión bien tomada. Esta confusión —“responde bien, luego decide bien”— es uno de los riesgos más peligrosos del uso acrítico de la IA.

La idea central se refuerza con una frase que resume todo el curso: la IA amplifica lo que somos. Si le entregamos claridad, amplifica claridad. Si le entregamos confusión, amplifica confusión. La IA no corrige automáticamente nuestras carencias; las multiplica. Por eso el progreso real no es tener más IA, sino usarla con mejor criterio.

El cierre del capítulo, y del curso, es deliberadamente sobrio y humano. No hay promesas grandilocuentes ni escenarios catastrofistas. La conclusión es clara: dominar la IA no consiste en saber más tecnología, sino en saber cuándo usarla, cómo usarla y, sobre todo, cuándo no delegar. La frase final sintetiza todo el aprendizaje recorrido: la inteligencia artificial amplifica nuestras decisiones, pero no las sustituye, y el verdadero progreso empieza cuando sabemos qué no debemos delegar.

Y, por último, gracias. Gracias por haber recorrido el curso completo con atención y criterio, sin quedarte solo en los titulares ni en la superficie. Si has llegado hasta aquí, puedes tener la tranquilidad de que ya posees un conocimiento profundo y bien estructurado sobre la inteligencia artificial: sabes cómo funciona, por qué a veces impresiona, por qué a veces falla y, sobre todo, dónde están sus límites reales. Estás preparado para usarla con conciencia, sin confundir fluidez con inteligencia ni potencia con responsabilidad. A partir de ahora, la IA deja de ser algo que “sorprende” o “asusta” y se convierte en lo que realmente es: una herramienta poderosa que puedes utilizar, guiar y dominar con criterio propio.

Aprendizaje de este capítulo

- La pregunta final sobre la IA no es técnica, es humana: qué papel queremos que tenga en nuestra vida y trabajo.

- La IA no decide su lugar; somos nosotros quienes lo definimos con nuestro uso.

- Una relación sana con la IA implica uso consciente, no delegación automática.

- Delegar tareas repetitivas y de bajo riesgo libera energía para el juicio humano.

- Usar IA para borradores, síntesis y exploración no reduce capacidad, la vuelve estratégica.

- Una relación sana no incluye delegar decisiones con consecuencias humanas.

- La IA no debe sustituir criterio, valores ni responsabilidad.

- Responder bien no equivale a decidir bien.

- La IA amplifica lo que el usuario le entrega: claridad o confusión.

- El progreso real no es “más IA”, sino mejor criterio al usarla.

- Dominar la IA es saber cuándo usarla… y cuándo no delegar.

Sigue avanzando

Lo interesante empieza cuando dejas de preguntarte qué puede hacer la IA y empiezas a decidir qué quieres construir con ella.

Has llegado al final de este curso, y eso ya marca una diferencia. Ahora tienes una base clara para entender cómo funciona la inteligencia artificial, cómo comunicarte mejor con ella y cuándo tiene sentido utilizarla… y cuándo no.

Desde aquí, ya no usas la IA por impulso ni por moda. A partir de ahora, formas parte de La Nueva Inteligencia: personas que usan la IA con criterio, intención y responsabilidad.

Bienvenido. El siguiente paso ya depende de ti.