Curso IA

Bloque 4 · IA y Lenguaje

Cómo trabaja la inteligencia artificial con texto

Después de entender cómo aprende una máquina y cómo está construida su arquitectura interna, en este bloque damos un paso decisivo: explicar cómo una IA moderna puede trabajar con lenguaje sin comprender su significado.

El lenguaje humano es una de las herramientas más complejas que usamos: es ambiguo, depende del contexto y está cargado de intención. Para una IA, sin embargo, el lenguaje no es significado ni experiencia. Es una secuencia estructurada que puede fragmentarse, compararse y transformarse siguiendo patrones. Este bloque fija ese cambio de perspectiva como base imprescindible para todo lo que viene después.

A lo largo de los capítulos veremos cómo el texto se convierte en una representación interna manejable, qué es un modelo de lenguaje y por qué su función principal es predecir la siguiente unidad de una secuencia. Entenderemos por qué la IA no “lee” palabras, sino fragmentos, cómo asigna relevancia a distintas partes del texto y cómo la coherencia emerge de un proceso puramente secuencial.

El bloque culmina mostrando que la fluidez del lenguaje generado no nace de ideas, intención ni comprensión, sino de cálculos probabilísticos sobre qué continuación es más plausible en cada momento. Esta explicación permite desmontar muchas confusiones habituales y sentar una base sólida para interpretar correctamente las respuestas de la IA, sin atribuirle capacidades que no tiene.

Con este marco claro, el curso queda preparado para avanzar hacia el siguiente nivel: qué implica interactuar con sistemas que generan lenguaje de forma tan convincente y qué criterios necesitamos para interpretarlos y evaluarlos con rigor.

CAPÍTULO 17

Qué significa que una IA trabaje con lenguaje

Resumen del capítulo

Hasta ahora hemos visto cómo funciona la inteligencia artificial desde el punto de vista del aprendizaje y de la arquitectura. En este punto del curso entramos en un terreno especialmente delicado: el lenguaje. Delicado porque es el lugar donde más fácilmente proyectamos comprensión, intención o mente allí donde no las hay.

Para los humanos, el lenguaje está cargado de significado, contexto, matices e intención. Una misma frase puede expresar cosas muy distintas según quién la diga, cuándo, cómo y por qué. Ese marco humano es tan natural para nosotros que tendemos a asumir que cualquier sistema que maneje lenguaje participa de él. Este capítulo corta de raíz esa suposición.

Desde el punto de vista de una máquina, el lenguaje no es significado ni experiencia. Es una secuencia ordenada de elementos que puede analizarse como patrón: orden, repetición, estructura. La IA no “sabe” qué quiere decir un texto ni qué intención hay detrás; lo que hace es procesar regularidades formales dentro de una secuencia. Ese cambio de perspectiva es imprescindible para entender todo lo que viene después en este bloque.

Este capítulo fija, por tanto, el marco mental correcto: la IA trabaja con lenguaje sin comprenderlo. Procesa secuencias, no significados. Y solo desde esa base se puede explicar con rigor cómo es posible generar texto coherente sin que exista comprensión humana detrás.

Aprendizaje de este capítulo

- El lenguaje humano y el lenguaje para una máquina no son lo mismo. Para las personas, el lenguaje está ligado a significado, intención y contexto; para una IA, el lenguaje es una estructura formal que puede analizarse sin referencia a ningún mundo interior.

- Que una IA trabaje con texto no implica que comprenda lo que ese texto “quiere decir”. Procesar lenguaje significa identificar y transformar patrones dentro de una secuencia, no interpretar su sentido.

- La ambigüedad del lenguaje humano es clave para entender este punto: una misma frase puede significar cosas distintas para nosotros, pero para la IA solo es una configuración concreta de una secuencia.

- Desde la perspectiva de la máquina, el texto se reduce a orden, repetición y estructura. No hay intención, no hay experiencia y no hay comprensión, solo tratamiento de secuencias.

- Interiorizar este marco evita uno de los errores más comunes al usar IA: confundir fluidez lingüística con comprensión real. Procesar lenguaje no es entenderlo, y este principio es la base de todo el bloque.

CAPÍTULO 18

Qué es un modelo de lenguaje

Resumen del capítulo

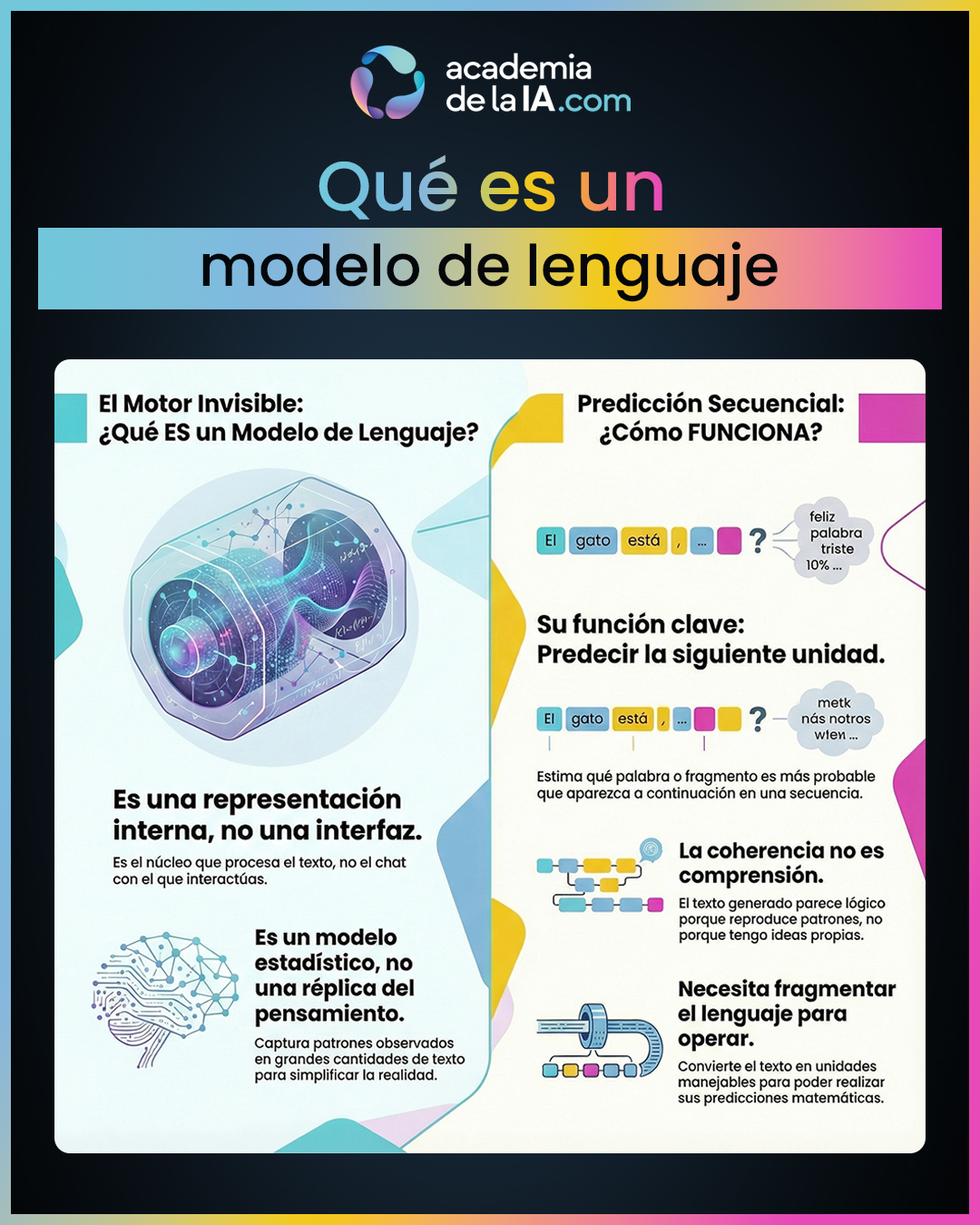

En el capítulo anterior fijamos una idea clave: para una IA, el lenguaje no es significado, sino secuencia. Pero para poder trabajar con esas secuencias de forma coherente, la máquina necesita algo más que texto sin procesar. Necesita una representación interna que capture regularidades, relaciones y patrones. Esa representación es lo que llamamos modelo de lenguaje.

Este capítulo introduce el concepto de modelo de lenguaje como el núcleo invisible del sistema, diferenciándolo claramente de las interfaces con las que interactuamos, como un chat. El modelo no “conversa”, no “responde” ni “dialoga”: opera internamente como un mecanismo matemático que representa cómo suele organizarse el lenguaje.

Un modelo de lenguaje se construye para capturar patrones estadísticos presentes en grandes volúmenes de texto. Su función no es entender ideas, sino estimar qué unidad es más probable a continuación dentro de una secuencia dada. Esa predicción secuencial es el corazón de todo su funcionamiento y explica por qué puede generar texto coherente sin comprender su contenido.

El capítulo prepara además el terreno para el siguiente paso lógico: si el modelo predice unidades dentro de una secuencia, primero es necesario definir cuáles son esas unidades y cómo se fragmenta el lenguaje para poder operar con él.

Aprendizaje de este capítulo

- Un modelo de lenguaje es la representación interna que permite a una IA trabajar con texto. No es una interfaz ni un chat, sino el motor invisible que captura regularidades del lenguaje.

- En IA, un “modelo” es una simplificación útil de la realidad: no reproduce el lenguaje humano, sino que representa estadísticamente patrones observados en grandes cantidades de texto.

- El funcionamiento central de un modelo de lenguaje es la predicción secuencial. Su objetivo es estimar qué unidad es más probable que aparezca a continuación dada una secuencia previa.

- La coherencia del texto generado no proviene de comprensión ni intención, sino de la capacidad del modelo para capturar y reproducir regularidades del lenguaje.

- Para poder predecir secuencias, el lenguaje debe convertirse en algo fragmentable y manejable por la máquina. Esta necesidad abre directamente la puerta al concepto de tokenización, que se abordará en el siguiente capítulo.

CAPÍTULO 19

Qué son los tokens y por qué importan

Resumen del capítulo

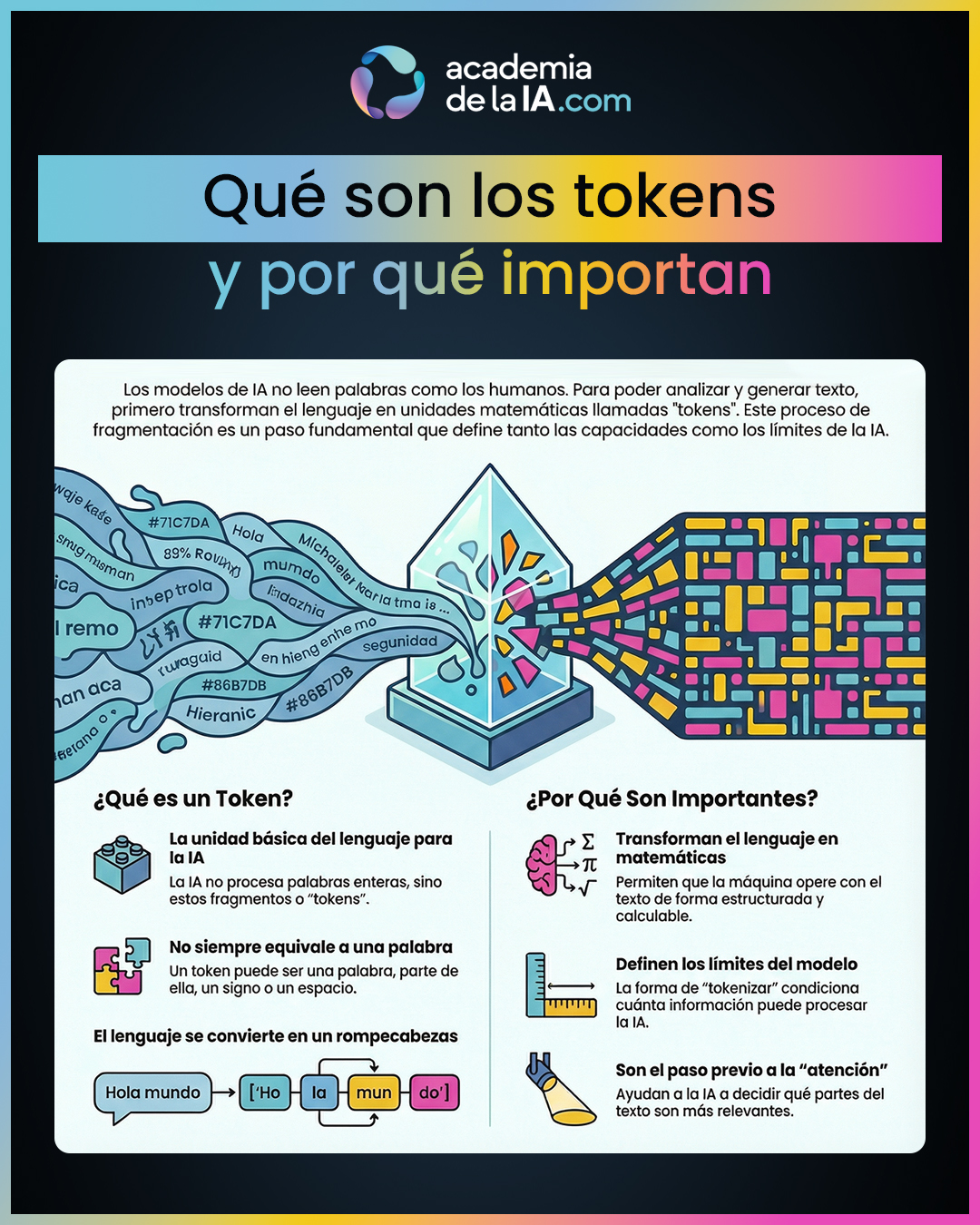

En el capítulo anterior vimos que un modelo de lenguaje funciona prediciendo la siguiente unidad dentro de una secuencia. Pero para que esa predicción sea posible, el lenguaje humano —continuo, flexible y lleno de matices— debe transformarse primero en algo que una máquina pueda manejar. Ese paso previo es la tokenización.

Este capítulo introduce una idea contraintuitiva pero fundamental: una IA no lee palabras ni frases como lo hace una persona. Para la máquina, el lenguaje se convierte en fragmentos discretos llamados tokens. Estos fragmentos son las piezas básicas con las que el modelo opera internamente, compara patrones y calcula probabilidades.

Entender qué es un token implica aceptar que no coincide necesariamente con una palabra, una sílaba o una letra. La fragmentación del lenguaje responde a criterios funcionales, no lingüísticos humanos. El texto se convierte en una secuencia de unidades manipulables, contables y combinables, que permiten al modelo trabajar con el lenguaje de forma matemática y estructurada.

El capítulo deja claro que esta fragmentación no es un detalle técnico menor, sino un factor que condiciona directamente los límites y el comportamiento del modelo. Cómo se divide el lenguaje determina qué puede procesar, cómo mantiene coherencia y hasta dónde llega su capacidad operativa. Con esta base, el curso prepara el salto al siguiente concepto clave: cómo decide el modelo qué partes de la secuencia son más relevantes en cada momento.

Aprendizaje de este capítulo

- Un token es la unidad básica con la que trabaja un modelo de lenguaje. La IA no procesa palabras completas, sino fragmentos que convierten el lenguaje en piezas discretas.

- La tokenización transforma el lenguaje continuo en una secuencia manejable por la máquina. Este paso es imprescindible para que el modelo pueda analizar, comparar y generar texto.

- Los tokens no coinciden necesariamente con palabras humanas. Pueden ser partes de palabras, combinaciones frecuentes o fragmentos funcionales definidos por el propio sistema.

- Al convertir el lenguaje en piezas contables, la IA puede operar con él de forma estructurada, pero pierde cualquier vínculo directo con el significado humano.

- La forma en que se fragmenta el lenguaje condiciona los límites del modelo: qué puede procesar, cuánta información maneja y cómo construye coherencia a lo largo de una secuencia.

- Comprender la tokenización permite entender por qué el siguiente paso no es “pensar mejor”, sino decidir qué partes del texto importan más en cada momento, lo que lleva directamente al concepto de atención.

CAPÍTULO 20

Qué es la atención y por qué cambió la IA del lenguaje

Resumen del capítulo

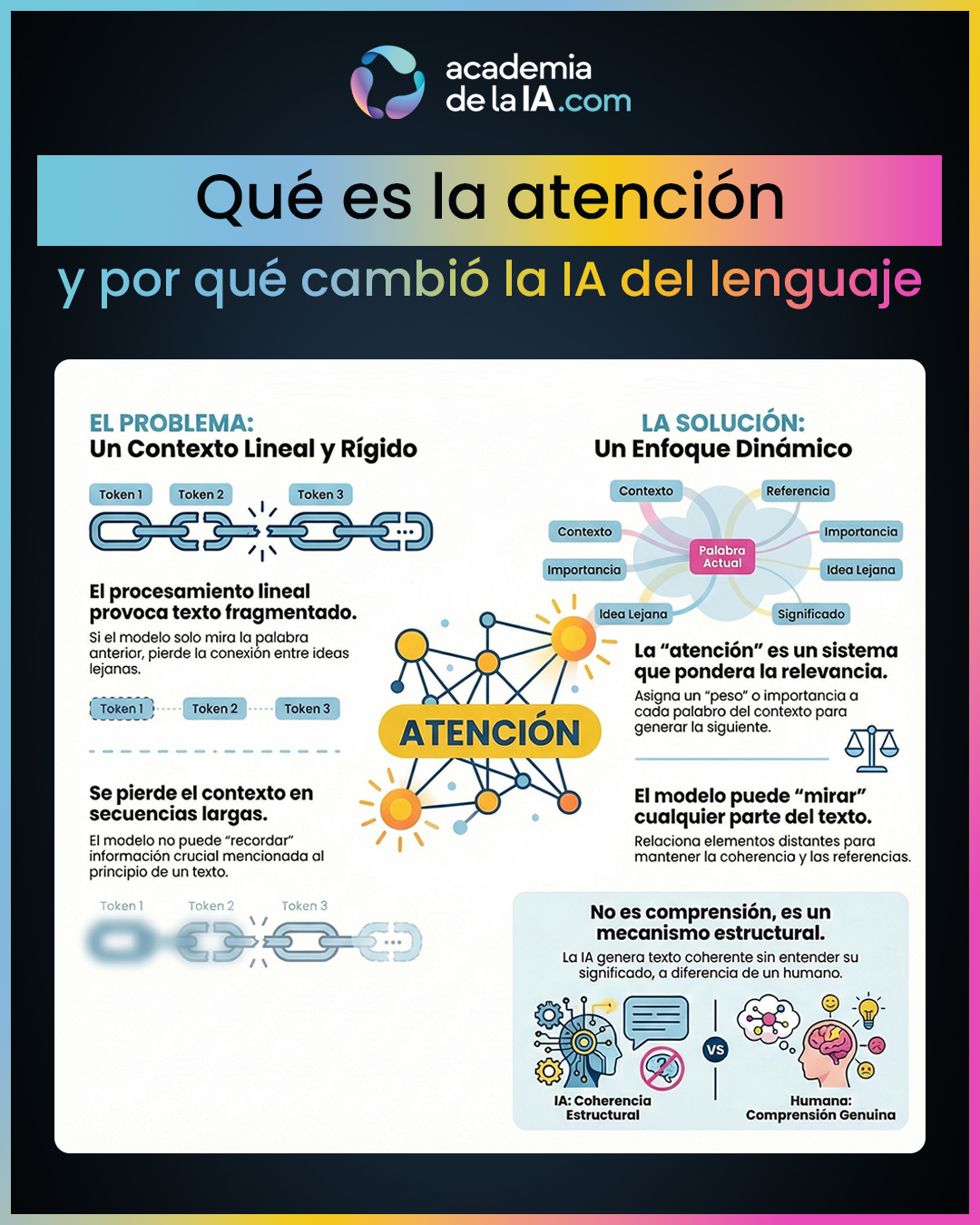

En el capítulo anterior vimos que, para una IA, el lenguaje se convierte en una secuencia de tokens. Pero esa secuencia, por sí sola, no garantiza coherencia. Si el modelo tratara todos los tokens por igual y en orden fijo, el resultado sería un texto fragmentado, con pérdidas de contexto y sin conexión entre ideas alejadas. Ese fue, de hecho, uno de los grandes límites de los primeros sistemas de lenguaje.

Este capítulo introduce el concepto de atención como el mecanismo que permite superar ese problema. La atención no añade comprensión ni intención, sino una forma estructurada de decidir qué partes del texto son más relevantes en cada momento. En lugar de procesar la secuencia de forma estrictamente lineal, el modelo puede “mirar” distintas partes del contexto y asignarles pesos distintos según su relevancia para generar el siguiente paso.

Gracias a la atención, la IA puede relacionar elementos que aparecen lejos entre sí en el texto, mantener referencias, recuperar información previa y construir coherencia a lo largo de secuencias más largas. El contexto deja de ser una simple cola de tokens y pasa a ser una red de relaciones dinámicas.

El capítulo subraya un punto clave: aunque el término “atención” suene humano, no lo es. No implica foco consciente ni comprensión. Es un mecanismo estructural que permite ponderar relevancia y conectar información distribuida. Esta distinción es esencial para entender tanto la potencia como los límites de la IA del lenguaje actual.

Aprendizaje de este capítulo

- La tokenización es necesaria, pero insuficiente para generar texto coherente. Sin un mecanismo adicional, el modelo pierde contexto y continuidad.

- La atención es un sistema de ponderación de relevancia: permite asignar más o menos peso a distintas partes del texto en cada paso de generación.

- La IA no procesa el lenguaje de forma estrictamente lineal. Gracias a la atención, puede relacionar tokens distantes y mantener coherencia a lo largo de la secuencia.

- La relevancia no es fija: cambia dinámicamente en cada momento según el contexto y lo que el modelo necesita para continuar el texto.

- El contexto pasa de ser una simple lista ordenada a una estructura relacional, donde distintas partes del texto influyen entre sí.

- La atención no es comprensión ni conciencia. Es una herramienta estructural que explica por qué la IA puede generar texto coherente sin entender su significado.

CAPÍTULO 21

Cómo genera texto una IA

Resumen del capítulo

En los capítulos anteriores hemos visto por qué las redes profundas permiten a la IA realizar tareas complejas sin reglas explícitas. En este capítulo damos un paso imprescindible: entender que esa potencia no es ilimitada. La arquitectura que habilita capacidades también impone límites claros.

Una red neuronal no es un sistema universal ni una mente general. Su comportamiento depende completamente de los datos y situaciones que ha visto durante su ajuste. Cuando el contexto se mantiene dentro de lo aprendido, puede rendir muy bien; cuando se sale de ese marco, el sistema puede fallar de formas inesperadas, incluso cuando parece seguro de sí mismo.

El capítulo subraya una diferencia clave: la red no comprende el problema que resuelve. No tiene un modelo del mundo, ni sentido común, ni capacidad de reinterpretar una situación nueva desde principios generales. Su “inteligencia” es local y contextual, no global.

Estos límites no son errores de implementación ni defectos corregibles con más potencia sin más. Son consecuencias directas de la arquitectura: depender de datos pasados implica fragilidad ante lo no visto. Este cierre prepara el terreno para entender por qué, a pesar de su alto rendimiento, muchas decisiones internas de la IA resultan opacas para los humanos.

Aprendizaje de este capítulo

- Que una red neuronal sea potente no significa que sea universal: funciona bien dentro de su contexto aprendido, no fuera de él.

- Su comportamiento depende totalmente de los datos con los que se ha ajustado; no puede extrapolar con garantías a mundos que no ha visto.

- La red puede producir respuestas correctas sin comprender lo que hace ni por qué lo hace.

- Fuera de su dominio, la IA puede mostrar fragilidad, errores inesperados o falsas seguridades.

- Estos límites no son accidentales: son una consecuencia directa de cómo está construida la arquitectura.

CAPÍTULO 22

Por qué la IA trabaja con probabilidades y no con ideas

Resumen del capítulo

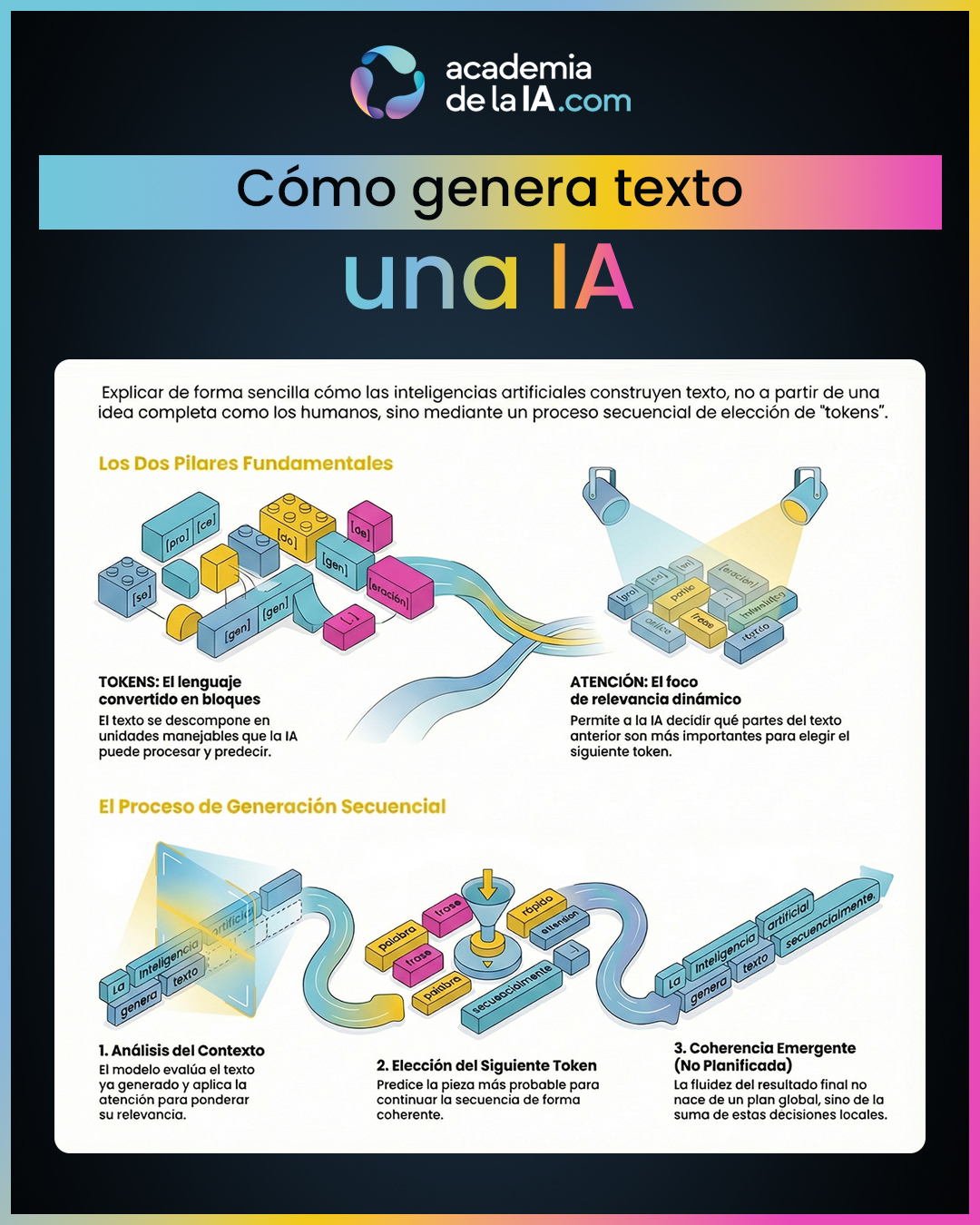

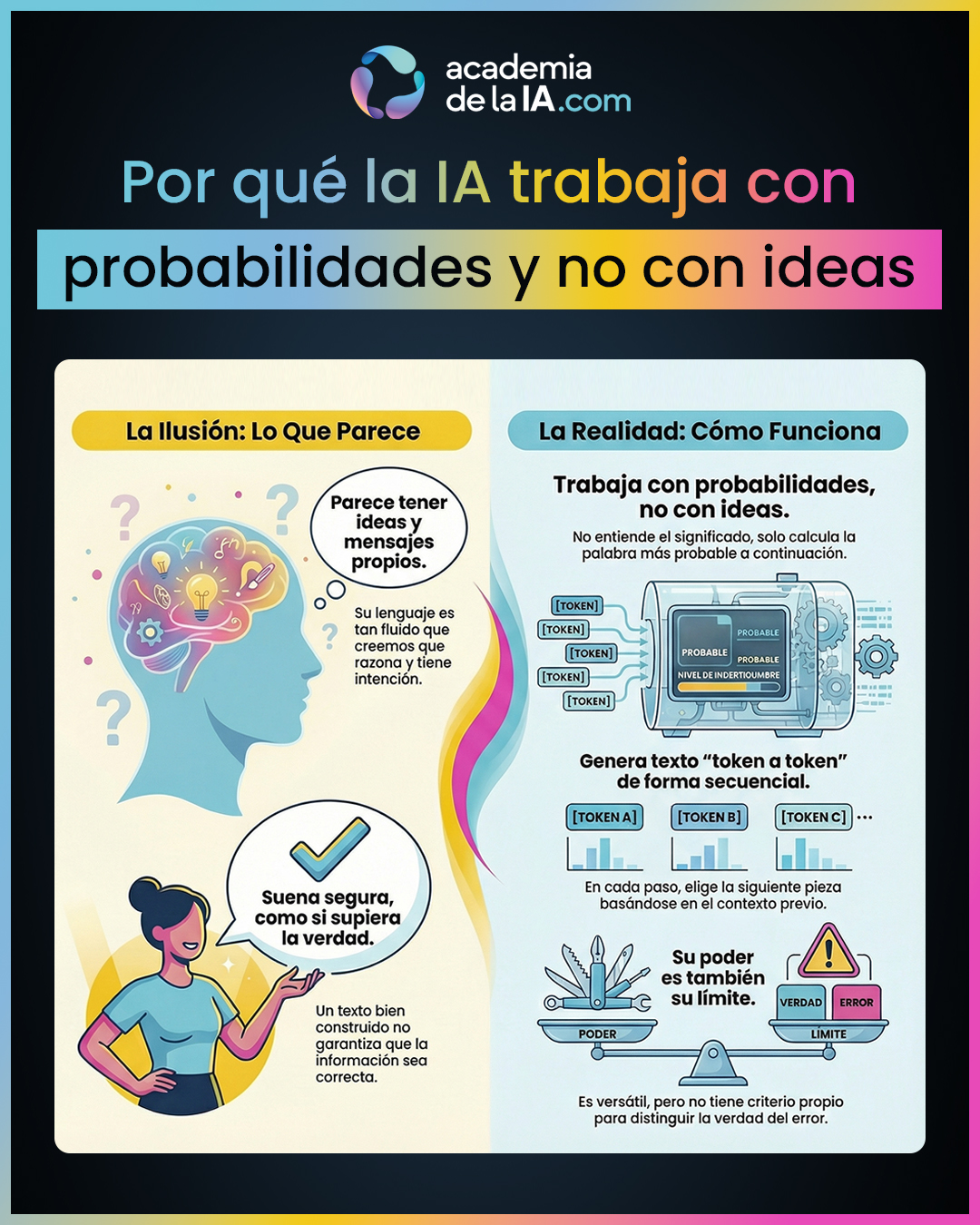

Después de entender que la IA genera texto de forma secuencial, token a token, este capítulo introduce el criterio real que guía cada una de esas elecciones. La fluidez del lenguaje que percibimos no surge porque la IA tenga ideas, intenciones o mensajes que quiera transmitir, sino porque opera sobre probabilidades. Este punto es clave para desactivar muchas confusiones habituales sobre cómo “piensa” una IA.

Cuando una IA genera texto, no decide qué es verdadero, relevante o correcto en sentido humano. Calcula, en cada paso, qué token es más probable dado el contexto previo. Ese contexto incluye los tokens anteriores y los pesos de atención que determinan qué partes influyen más en la siguiente predicción. El núcleo del proceso no es semántico, sino estadístico: elegir lo más probable dentro de un conjunto de posibilidades.

Este enfoque explica por qué la IA puede producir textos muy fluidos incluso cuando el contenido es incorrecto, impreciso o contradictorio. La fluidez es una propiedad del encadenamiento probabilístico, no una garantía de verdad ni de comprensión. Un texto puede sonar bien porque sigue patrones frecuentes del lenguaje, aunque no esté anclado en hechos o ideas consistentes.

El capítulo cierra el bloque de lenguaje mostrando que esta base probabilística es, al mismo tiempo, la fuente de la potencia y de los límites de la IA. Gracias a ella, el sistema puede generar texto coherente en una enorme variedad de contextos; pero por la misma razón, no tiene criterio interno para distinguir verdad, intención o significado. Con este marco completo, el curso queda preparado para dar el salto al siguiente bloque, donde ya no se analizará cómo funciona por dentro, sino cómo interactuamos con ella y qué implicaciones tiene.

Aprendizaje de este capítulo

- La IA no trabaja con ideas, significados ni intenciones: trabaja con probabilidades calculadas a partir del contexto disponible.

- En cada paso de generación, el sistema evalúa una distribución de posibles tokens y selecciona el más probable según ese contexto.

- La probabilidad es condicionada: lo que viene después depende de lo que ya se ha generado y de cómo se pondera ese contexto mediante atención.

- La fluidez del lenguaje no implica verdad, corrección ni comprensión; solo indica que la secuencia es estadísticamente plausible.

- Un texto puede sonar seguro y bien construido incluso cuando el contenido es erróneo, porque la probabilidad no distingue entre “decir bien” y “decir verdad”.

- La ausencia de significado interno explica por qué la IA no tiene criterio propio: no sabe si algo es correcto, solo si es probable.

- Entender esta base probabilística permite usar la IA con más realismo, y prepara el terreno para el siguiente bloque, centrado ya en la relación entre la IA y el juicio humano.

¿Listo para el siguiente paso?

El conocimiento se construye capa por capa.

Continúa tu recorrido por los siguientes bloques, donde profundizarás en cómo funciona la IA, aprenderás a comunicarte con ella y desarrollarás criterio para un uso responsable.