Curso IA

Bloque 5 · Interacción

Qué ocurre cuando hablamos con una IA y por qué responde como responde

Hasta aquí has entendido qué es la IA, cómo aprende, cómo está construida por dentro y cómo consigue generar lenguaje sin comprenderlo. En este bloque damos el salto decisivo: pasamos de “cómo funciona” a “qué ocurre cuando tú interactúas con ella”. Porque, en la práctica, la experiencia real de la IA no es un laboratorio ni un modelo abstracto: es un chat. Y para usarlo con criterio hay que entender el mecanismo de esa conversación.

Aquí vas a ver qué pasa exactamente desde que escribes una pregunta hasta que aparece una respuesta. No como metáfora, sino como proceso: tu input entra en un sistema, se prepara, se combina con el contexto disponible y se genera una salida paso a paso. Esto aclara por qué la formulación importa tanto, por qué dos preguntas parecidas pueden producir respuestas muy distintas y por qué la fluidez puede engañar: el sistema está optimizado para coherencia y continuidad, no para “comprensión” humana.

Después aparece el primer gran salto práctico de utilidad: cuando la IA puede apoyarse en documentos. Entenderás RAG como idea simple —recuperar información y luego generar— y por qué cambia el tipo de respuestas que puede dar. A continuación, pondremos orden en una palabra muy mal entendida: “prompt”. No como “truco”, sino como lo que realmente es: el marco de actuación que guía enfoque, forma y límites. Y también aclararemos qué significa “personalizar” una IA, separando tres niveles que suelen confundirse: instrucciones, contexto y entrenamiento.

El bloque cierra con dos temas que explican la cara más peligrosa y más confusa de la interacción: por qué la IA puede equivocarse con seguridad (alucinaciones) y por qué el contexto no es memoria, aunque a veces lo parezca. Con todo esto, el alumno termina este bloque con una comprensión realista de la conversación con IA: qué la hace potente, qué la hace frágil y por qué el usuario forma parte del resultado. Y con esa base ya sí tiene sentido entrar en el Bloque 6, donde aprenderá a comunicarse mejor con la IA de forma práctica y controlada, sin depender de intuición.

CAPÍTULO 23

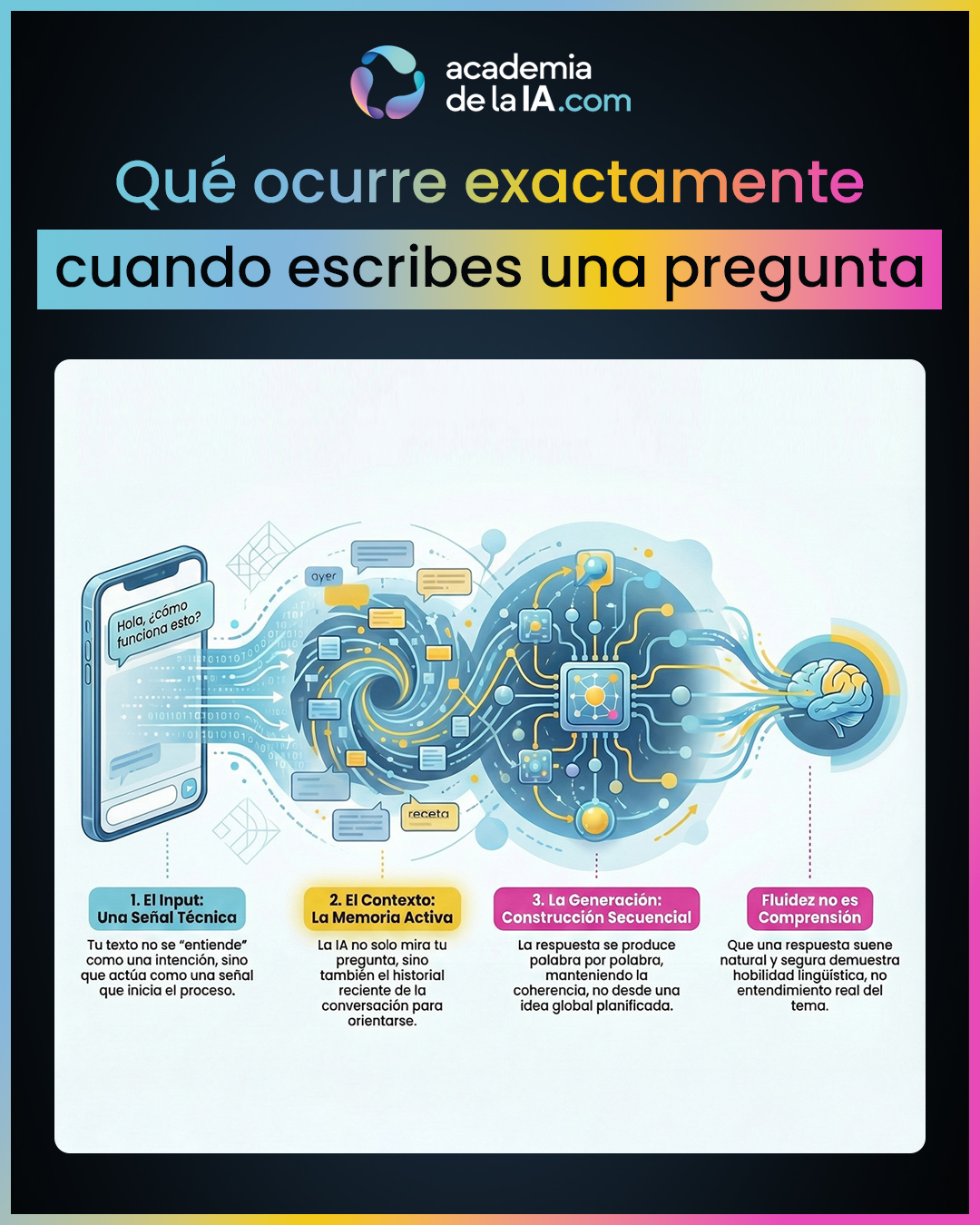

Qué ocurre exactamente cuando escribes una pregunta

Resumen del capítulo

Hasta ahora has aprendido cómo funciona la IA por dentro y por qué es capaz de generar lenguaje coherente sin comprenderlo. En este capítulo damos un paso clave: aterrizamos todo ese conocimiento en la experiencia real que tiene cualquier usuario, que no es otra que escribir en un chat y recibir una respuesta. Aquí conectamos la teoría con la práctica sin convertirlo en un manual ni en un tutorial.

Cuando escribes una pregunta, no estás dialogando con una mente ni iniciando una conversación humana. Estás activando un proceso técnico compuesto por varias etapas encadenadas. Tu texto entra en el sistema como una señal, se transforma en una representación interna manejable, se interpreta junto con el contexto disponible en ese momento y, a partir de ahí, se genera una respuesta de forma secuencial. Nada ocurre de golpe ni “desde una idea previa”: el texto se construye mientras aparece.

Este recorrido explica por qué una IA puede responder de forma brillante en un caso y torcerse en otro, incluso con preguntas parecidas. También aclara una ilusión muy común: la sensación de que “ha pensado” la respuesta. En realidad, lo que percibes como razonamiento es el resultado de un proceso optimizado para continuidad y fluidez. Entender este pipeline es fundamental para no confundir buena expresión con comprensión real, y para empezar a distinguir entre un chat genérico y sistemas que pueden apoyarse en información externa, algo que veremos en el siguiente capítulo.

Aprendizaje de este capítulo

- Escribir una pregunta no inicia un diálogo humano, sino un proceso técnico. El sistema no “escucha” ni “interpreta” como una persona: recibe un input y activa una cadena de transformaciones internas que desembocan en una respuesta generada paso a paso.

- El input es una señal que marca dirección, no una intención entendida. Para la IA, tu texto es material de trabajo que orienta el proceso, pero no contiene significado humano ni propósito consciente. La forma del input condiciona el tipo de salida que se construye.

- El contexto activo es tan importante como la pregunta. La respuesta no se genera solo a partir de lo que escribes ahora, sino de lo que el sistema tiene “a la vista” en ese momento: el hilo reciente, el marco de la conversación y cualquier información disponible en ese instante.

- La generación es secuencial, no planificada globalmente. La IA no decide primero “qué va a decir” y luego lo escribe. Va produciendo la respuesta pieza a pieza, manteniendo coherencia local con lo ya generado, lo que crea la sensación de pensamiento continuo.

- La fluidez no es una prueba de comprensión. Que una respuesta suene natural, segura y bien estructurada indica que el sistema sabe generar lenguaje, no que entienda el contenido ni que tenga memoria humana. Confundir esto es el origen de muchas expectativas erróneas.

CAPÍTULO 24

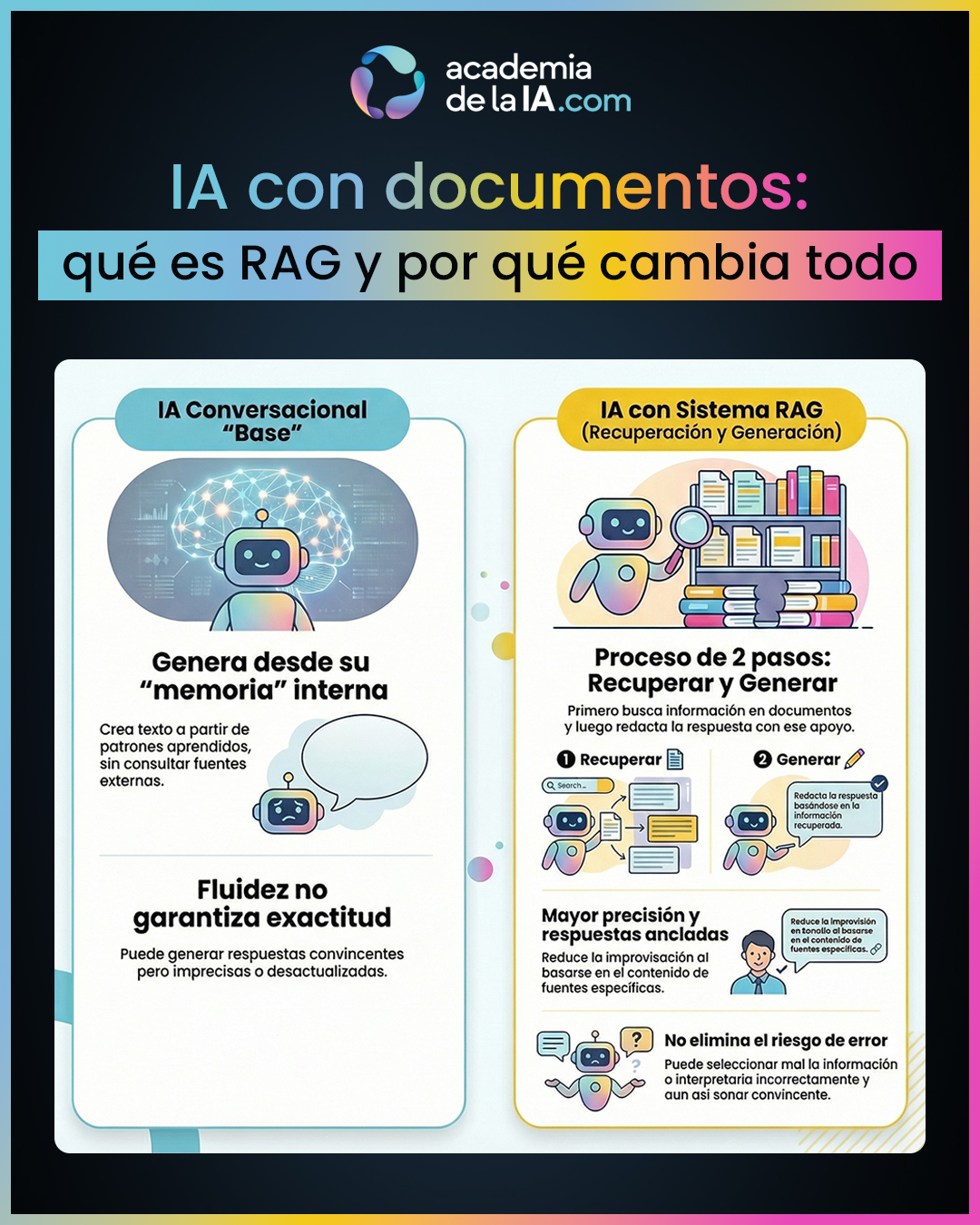

IA con documentos: qué es RAG y por qué cambia todo

Resumen del capítulo

En el capítulo anterior hemos visto qué ocurre internamente cuando escribes una pregunta y por qué una IA conversacional puede generar respuestas fluidas sin estar consultando ninguna fuente externa. Ese marco es clave para entender el límite natural de un modelo “base”: puede hablar bien de casi cualquier cosa, pero eso no significa que esté comprobando datos ni accediendo a información fiable en tiempo real.

En este capítulo aparece un salto conceptual importante: la diferencia entre una IA que genera únicamente desde dentro y una IA que puede apoyarse en documentos. RAG —recuperar y generar— introduce un paso previo al proceso habitual: antes de redactar la respuesta, el sistema busca información relevante en una colección de documentos y utiliza ese contenido como apoyo para generar el texto final. No cambia la naturaleza del modelo, pero sí cambia de dónde sale la información que utiliza.

Este enfoque mejora de forma clara la precisión y reduce la improvisación típica de un chat genérico, porque la respuesta queda anclada a contenidos concretos. Sin embargo, el capítulo también fija un límite esencial: RAG no convierte a la IA en infalible. El sistema puede recuperar información incorrecta, incompleta o irrelevante, y aun así redactar una respuesta convincente. La mejora es real, pero no absoluta. Por eso, incluso con documentos, sigue habiendo un factor decisivo que veremos a continuación: el marco que tú estableces al pedir la respuesta.

Aprendizaje de este capítulo

- Un modelo base no es una base de datos. Una IA conversacional estándar no consulta internet ni tus archivos por defecto. Genera texto a partir de patrones aprendidos, lo que le da fluidez, pero no garantiza exactitud ni actualización.

- RAG introduce un apoyo externo, no una “inteligencia mayor”. El sistema no se vuelve más listo en ese momento: simplemente añade un paso previo en el que recupera información relevante y luego genera la respuesta apoyándose en ella.

- La lógica de RAG es sencilla: primero recuperar, luego generar. Esta separación es clave para entender por qué mejora la calidad: la redacción se construye a partir de contenidos concretos, no solo desde patrones internos.

- La precisión mejora cuando la información está en los documentos. RAG reduce la improvisación, ancla la respuesta a fuentes específicas y es especialmente útil cuando el conocimiento relevante está bien definido y accesible.

- RAG no elimina el riesgo de error. El sistema puede seleccionar mal, mezclar fragmentos o interpretar incorrectamente lo recuperado, y aun así expresarlo con seguridad. La fluidez sigue sin ser garantía de verdad.

CAPÍTULO 25

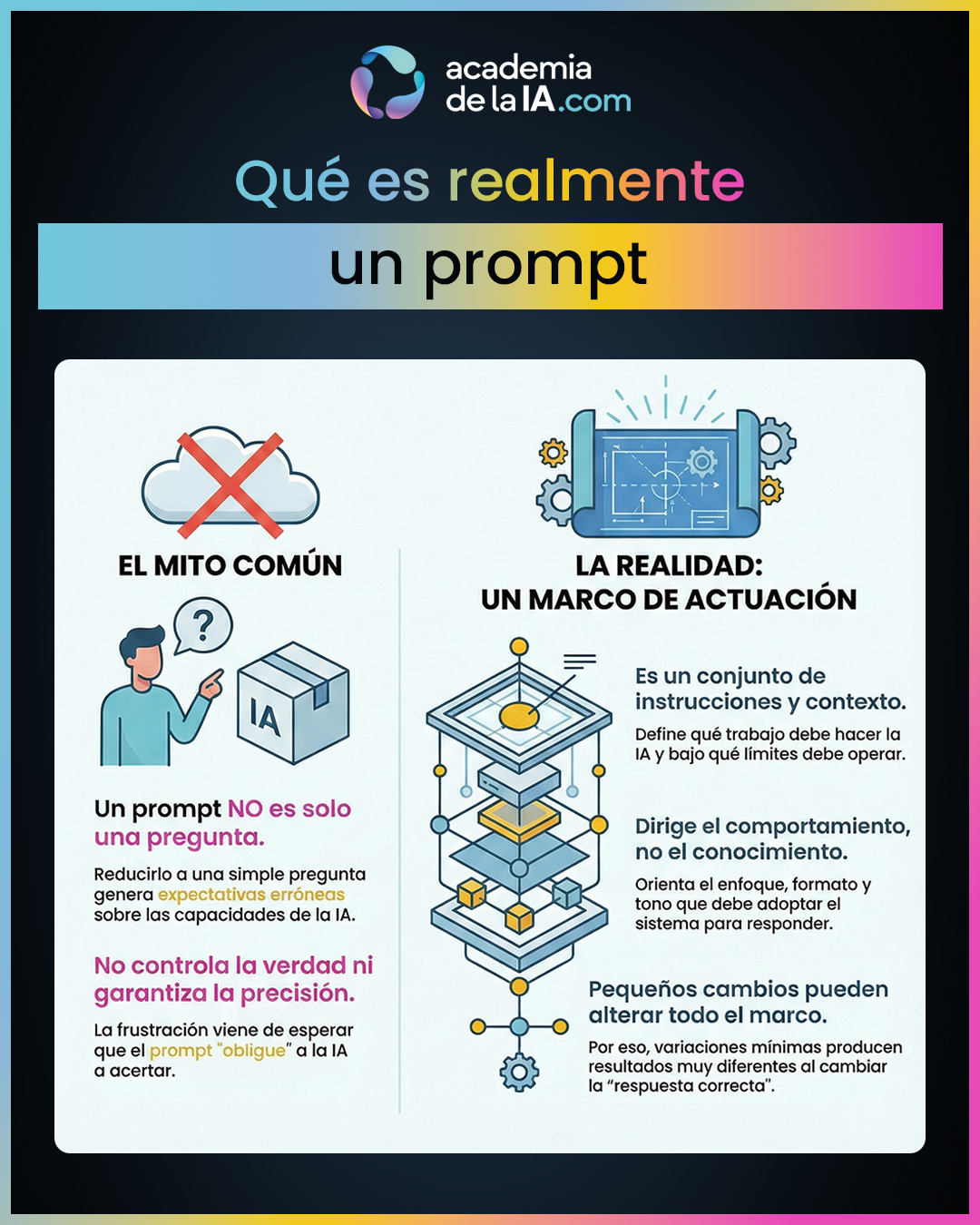

Qué es realmente un prompt

Resumen del capítulo

Después de entender cómo una IA genera respuestas y cómo puede apoyarse en documentos, este capítulo aclara un concepto que suele estar mal entendido desde el principio: qué es realmente un prompt. En el uso cotidiano se suele reducir a “la pregunta que haces”, pero esa simplificación es engañosa y genera muchas expectativas erróneas sobre lo que la IA puede y no puede hacer.

Aquí se fija una definición más precisa y operativa. Un prompt no es solo una frase inicial, sino el marco completo que define el trabajo que el sistema va a realizar en esa interacción. Incluye la instrucción, el contexto inmediato y las señales que orientan cómo debe construirse la respuesta. No le dice a la IA qué es verdad, pero sí le dice qué tipo de respuesta considera válida dentro de ese marco.

El capítulo también explica por qué pequeñas variaciones en un prompt pueden producir resultados muy distintos. No es una cuestión de palabras “mágicas”, sino de cambio de marco: cuando cambias el marco, cambias lo que el sistema entiende como una buena respuesta. Por eso, dos prompts parecidos pueden dar salidas muy diferentes sin que el modelo haya cambiado en absoluto.

El cierre deja clara una idea fundamental para el resto del bloque: el prompt no controla la verdad ni elimina el error, pero sí dirige el comportamiento del sistema. Y si el prompt actúa como marco, el siguiente paso lógico es entender qué significa realmente “personalizar” una IA y qué mecanismos existen para hacerlo.

Aprendizaje de este capítulo

- Un prompt no es solo una pregunta. Es el conjunto de instrucciones y contexto inmediato que define qué trabajo debe hacer la IA en esa interacción y bajo qué límites debe hacerlo.

- El prompt actúa como marco de actuación. No decide si algo es verdadero o falso, pero sí orienta qué enfoque, nivel, formato y tono considera adecuados el sistema para responder.

- Cambiar un prompt es cambiar el marco, no las palabras. Variaciones pequeñas pueden producir resultados muy distintos porque alteran la forma en que el modelo evalúa qué respuesta es “correcta” dentro de ese contexto.

- El prompt controla dirección, no conocimiento. Puede guiar cómo se expresa la respuesta, qué prioriza y qué deja fuera, pero no añade información nueva ni garantiza precisión.

- Entender bien qué es un prompt evita frustración. Muchas decepciones vienen de esperar que el prompt “obligue” a la IA a acertar, cuando en realidad solo puede orientar su comportamiento.

CAPÍTULO 26

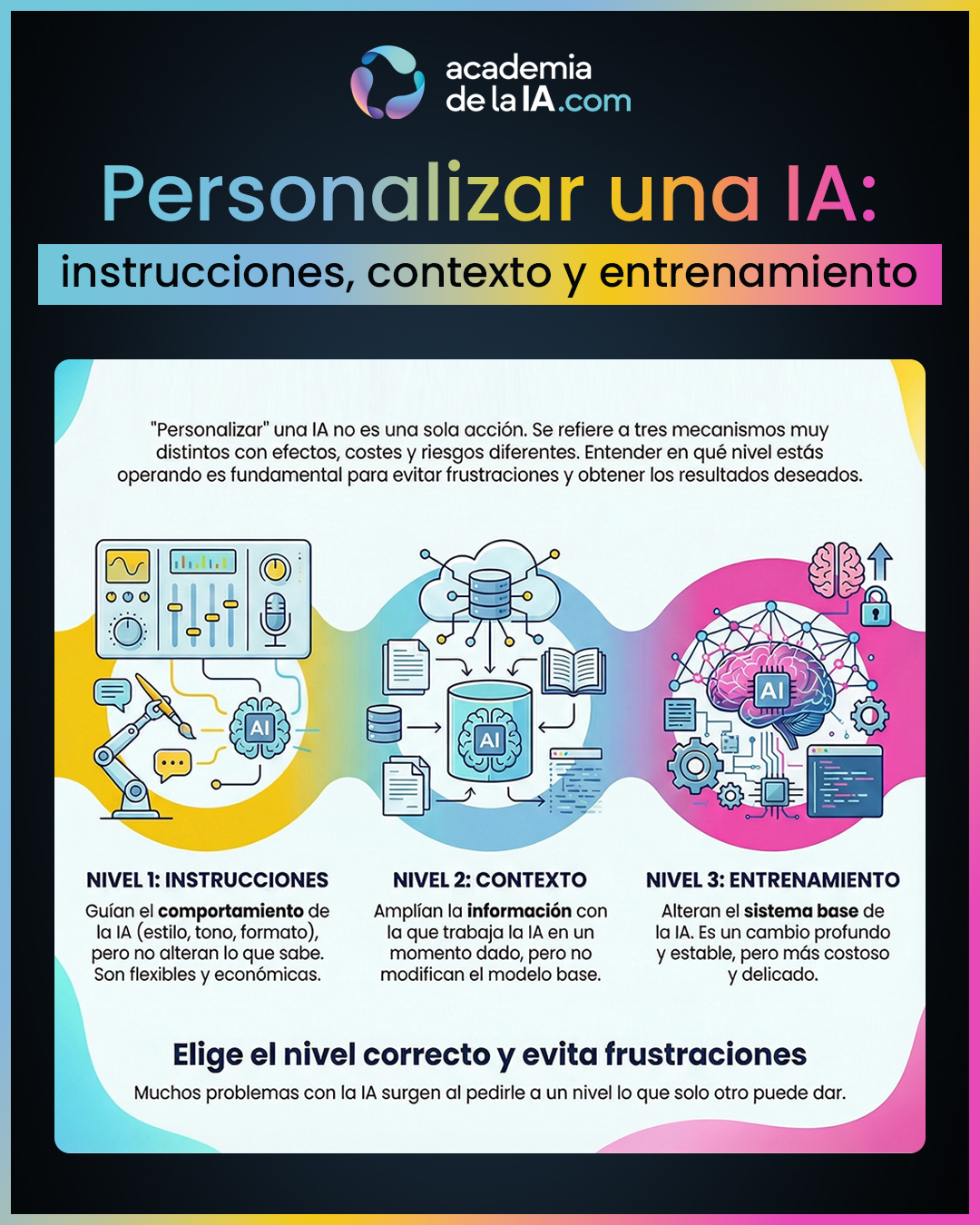

Personalizar una IA: instrucciones, contexto y entrenamiento

Resumen del capítulo

Después de definir correctamente qué es un prompt, este capítulo pone orden en otro concepto que suele generar mucha confusión: la personalización de una IA. En el discurso habitual, “personalizar” se usa como si fuera una sola cosa, cuando en realidad se refiere a tres mecanismos muy distintos, con efectos, costes y riesgos completamente diferentes.

El capítulo establece una distinción clara entre instrucciones, contexto y entrenamiento. El primer nivel, las instrucciones, actúa como una guía de comportamiento: define cómo debe responder la IA, pero no altera lo que sabe. Es flexible, barato y reversible, y sirve para adaptar el estilo, el tono o el enfoque sin tocar la base del sistema.

El segundo nivel es el contexto. Aquí no se cambia cómo responde la IA, sino con qué información trabaja en ese momento. Aportar documentos o datos amplía el marco informativo disponible, pero el modelo sigue siendo el mismo. La IA no “aprende” en sentido estructural: simplemente se apoya en una base distinta para generar la respuesta.

El tercer nivel es el entrenamiento, que sí implica un cambio más profundo. Entrenar busca modificar el comportamiento base del sistema, lo que lo hace más estable a largo plazo, pero también más costoso y delicado. No es una extensión puntual, sino una alteración del modo en que el modelo responde de forma general.

El cierre subraya una idea clave para evitar frustraciones: muchos problemas con la IA no vienen de la tecnología, sino de no saber en qué nivel de personalización se está actuando. Y deja preparado el terreno para el siguiente capítulo, donde se introduce un factor que atraviesa todos los niveles: la calidad de lo que el usuario comunica.

Aprendizaje de este capítulo

- “Personalizar” no es una sola cosa. Instrucciones, contexto y entrenamiento son mecanismos distintos, y confundirlos lleva a expectativas irreales sobre lo que una IA puede hacer.

- Las instrucciones guían el comportamiento, no el conocimiento. Cambian cómo responde la IA —estilo, enfoque, formato— pero no modifican su base de información ni su capacidad real.

- El contexto amplía la información disponible, no el modelo. Aportar documentos o datos permite respuestas más ancladas, pero la IA sigue funcionando con el mismo comportamiento base.

- El entrenamiento sí altera la base del sistema. Es más estable y profundo, pero también más costoso y arriesgado, porque modifica la forma general en que responde la IA.

- Saber en qué nivel estás evita frustraciones. Muchas decepciones nacen de pedirle a un nivel de personalización lo que solo puede dar otro.

CAPÍTULO 27

Por qué preguntar bien es más importante que saber mucho

Resumen del capítulo

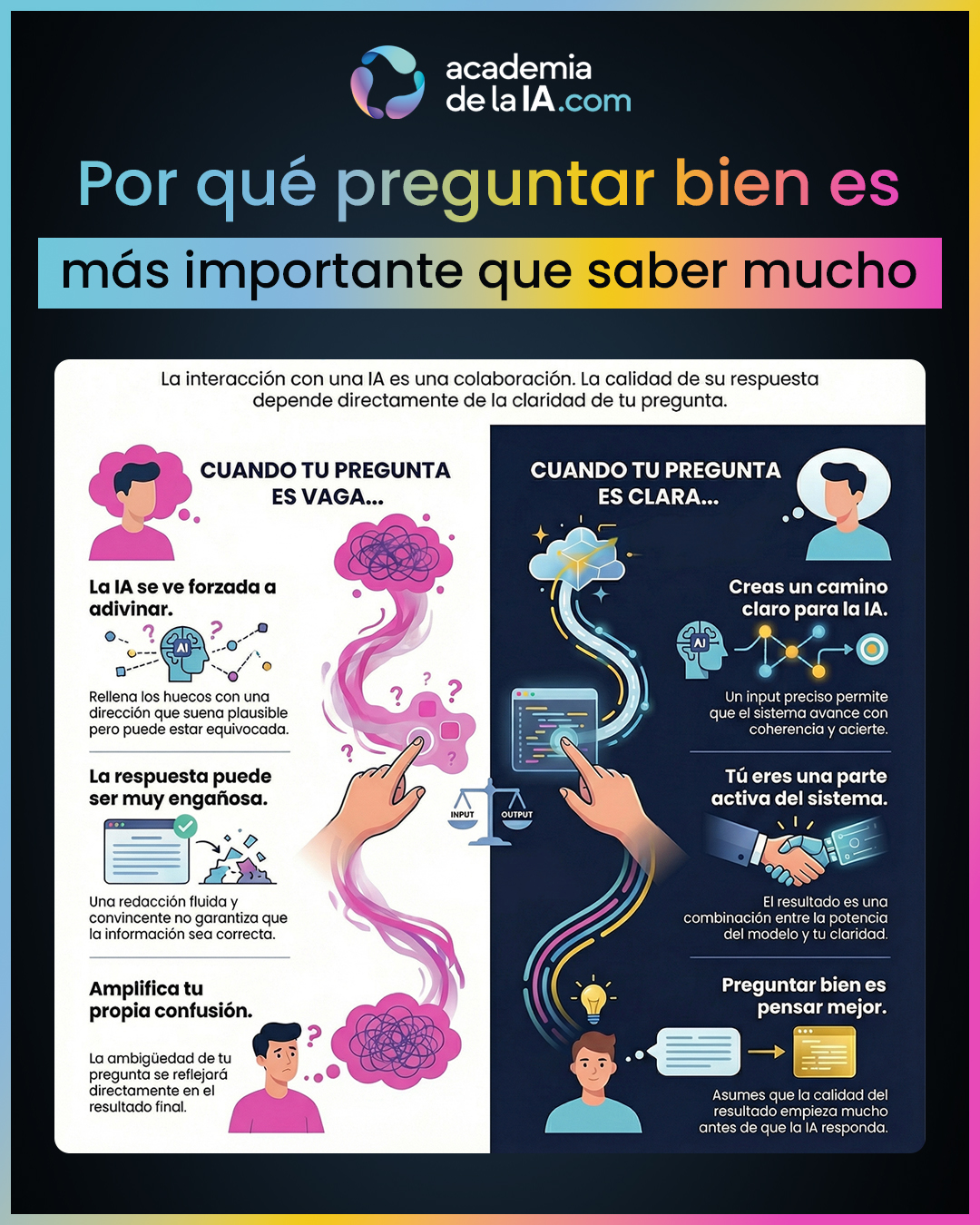

Este capítulo introduce una idea clave que suele resultar incómoda, pero es fundamental para entender la interacción con una IA: el usuario no es un observador externo, sino una parte activa del sistema. La calidad de la respuesta no depende solo de la capacidad del modelo, sino de la claridad del input que recibe.

Se desmonta la creencia de que la IA “responde mejor que tú piensas”. En realidad, responde a partir del marco que tú defines. Cuando la pregunta es vaga, ambigua o mal planteada, el sistema tiene que inferir qué se espera de él. A veces acierta, pero otras veces rellena huecos inventando una dirección plausible. El resultado puede sonar fluido y convincente, aunque esté mal orientado.

El capítulo subraya que la claridad no es un detalle estético, sino el factor que marca el techo del resultado. Un input claro crea un carril por el que la IA puede avanzar con coherencia. Un input confuso obliga al sistema a improvisar. Y esa improvisación es especialmente peligrosa porque no siempre es evidente para el usuario.

El cierre conecta directamente con el siguiente tema: incluso cuando la pregunta está bien formulada, existen fallos que no se detectan fácilmente, porque el sistema puede equivocarse con una seguridad que engaña. Ese es el problema que se aborda a continuación.

Aprendizaje de este capítulo

- El usuario forma parte del sistema. En una conversación con IA, el resultado no es solo “lo que hace la máquina”, sino la combinación entre el modelo y la claridad del input.

- La IA no sustituye tu pensamiento. No corrige automáticamente una pregunta confusa; amplifica tanto la claridad como la ambigüedad que le das.

- Una pregunta vaga obliga al sistema a adivinar. Y cuando adivina, puede construir una respuesta coherente pero mal dirigida, sin que el error sea evidente.

- La fluidez puede engañar. Una respuesta bien escrita no garantiza que la pregunta estuviera bien planteada ni que la dirección sea correcta.

- Preguntar bien es una forma de pensar mejor. No es una técnica avanzada ni un truco: es asumir que la calidad del resultado empieza antes de que la IA responda.

CAPÍTULO 28

Por qué la IA puede equivocarse con tanta seguridad

Resumen del capítulo

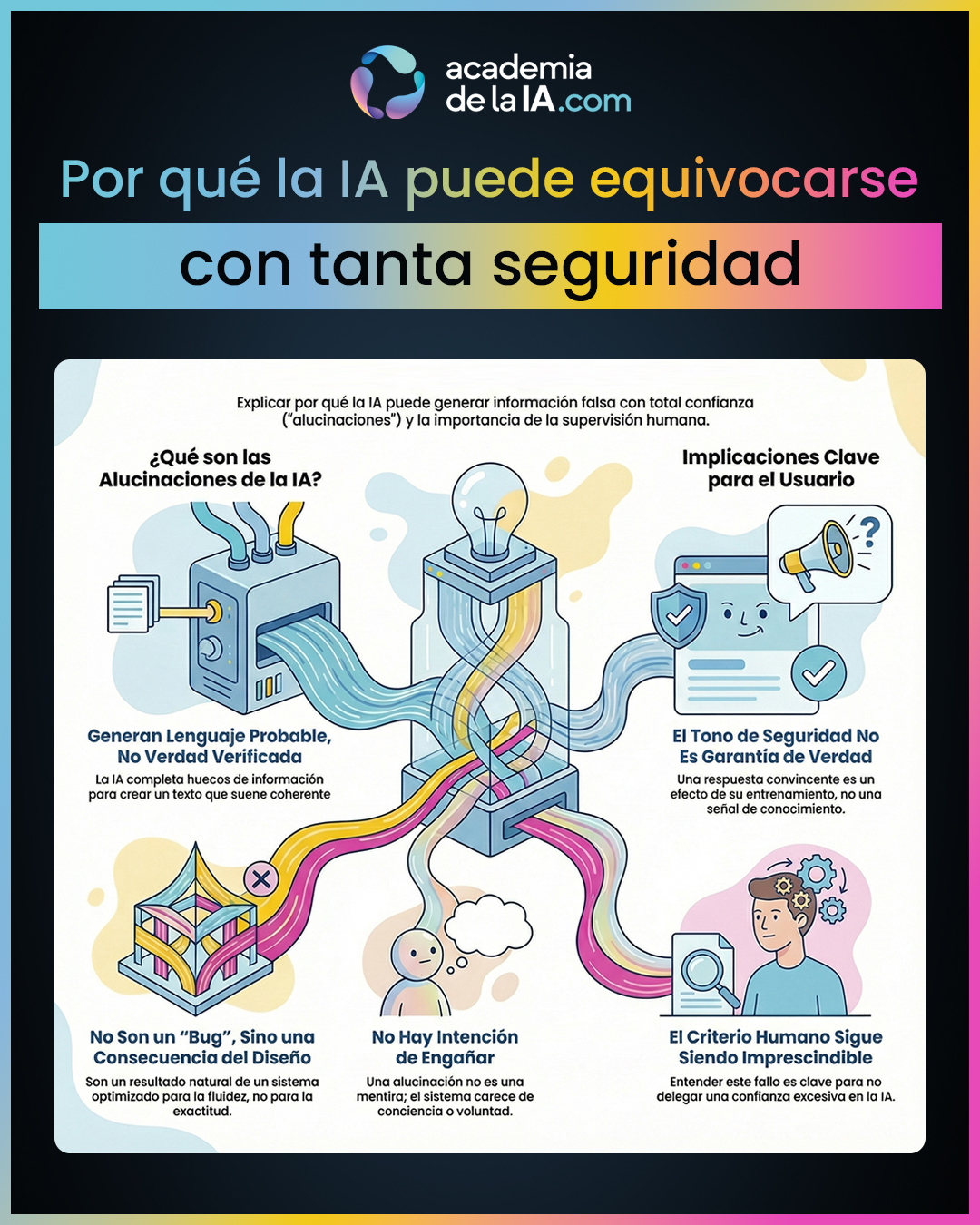

Este capítulo aborda uno de los fenómenos más desconcertantes de la interacción con IA: su capacidad para afirmar cosas falsas con una seguridad absoluta. Lejos de ser un error raro o un fallo puntual, este comportamiento tiene una causa estructural que conviene entender bien antes de avanzar.

Se introduce el concepto de alucinación como una consecuencia directa del modo en que el sistema genera lenguaje. La IA no está optimizada para comprobar la verdad de lo que dice, sino para producir texto coherente y fluido a partir del contexto disponible. Cuando dispone de información suficiente, puede acertar con gran precisión. Pero cuando esa base es incompleta, ambigua o inexistente, el sistema no “se detiene”: completa los huecos con lo que resulta más probable desde el punto de vista del lenguaje.

El capítulo aclara un punto clave: una alucinación no es una mentira intencional. No hay voluntad, intención ni conciencia del error. El sistema simplemente continúa el texto de la forma que mejor encaja con el contexto, incluso aunque el contenido sea incorrecto.

Se explica también por qué estas respuestas suenan tan creíbles. El lenguaje humano asocia fluidez, coherencia y seguridad verbal con conocimiento. Pero en la IA, el tono firme no es un indicador de verdad, sino un efecto secundario de su entrenamiento para generar lenguaje continuo y seguro.

El cierre deja clara una consecuencia fundamental: el criterio humano sigue siendo imprescindible. Y prepara el terreno para el siguiente capítulo introduciendo una ilusión especialmente peligrosa, que intensifica este problema: la sensación de que la IA “recuerda” y, por tanto, merece más confianza de la que realmente tiene.

Aprendizaje de este capítulo

- Las alucinaciones no son un bug raro. Son una consecuencia natural de generar lenguaje probable sin un verificador interno de verdad.

- La IA prioriza coherencia y fluidez, no exactitud. Cuando falta información suficiente, el sistema completa huecos en lugar de detenerse.

- No hay intención de engaño. Una alucinación no es una mentira consciente, sino un resultado automático del proceso de generación.

- La seguridad del tono no indica verdad. En IA, una respuesta convincente puede ser incorrecta sin mostrar señales externas de duda.

- El criterio humano sigue siendo imprescindible. Entender por qué la IA puede equivocarse con tanta seguridad es clave para no delegar confianza de más.

CAPÍTULO 29

Qué significa que la IA no tenga memoria real

Resumen del capítulo

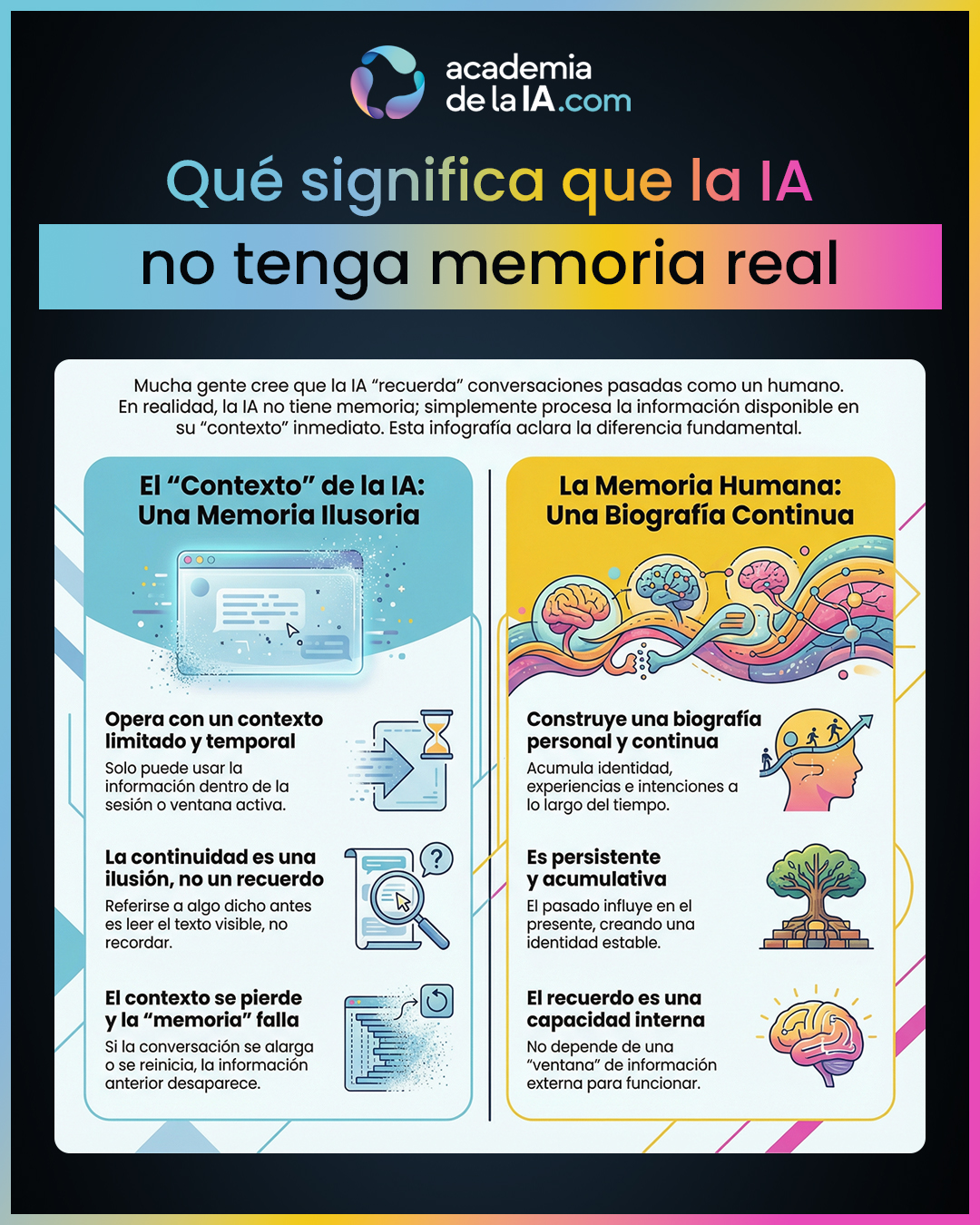

Este capítulo cierra el bloque abordando una de las ilusiones más comunes —y más peligrosas— en la interacción con IA: la sensación de que “recuerda”. Muchas personas perciben continuidad en la conversación y asumen que el sistema conserva información personal, decisiones pasadas o una especie de biografía interna. Esa percepción altera la confianza y puede llevar a conclusiones equivocadas sobre sus capacidades reales.

Aquí se establece con claridad la diferencia entre memoria humana y contexto operativo. La IA no recuerda en sentido humano. No mantiene identidad, experiencia acumulada ni intención a lo largo del tiempo. Lo que hace es trabajar únicamente con la información que tiene disponible en ese momento para generar la siguiente respuesta.

Se define el contexto como el conjunto de elementos visibles para el sistema en una interacción concreta: partes recientes de la conversación, instrucciones activas y el marco inmediato desde el que se genera la respuesta. Mientras esa información está “a la vista”, la IA puede referirse a ella y mantener una continuidad aparente.

El capítulo explica por qué esa continuidad se percibe como memoria. Cuando el sistema responde de forma coherente y enlaza con algo dicho antes, el cerebro humano interpreta esa referencia como recuerdo. Pero no lo es: es simplemente lectura del contexto disponible.

También se aclara por qué esa continuidad se pierde. El contexto tiene límites. Cuando la conversación se alarga, cambia de sesión o supera la ventana disponible, parte de la información deja de estar accesible. En ese momento, la IA ya no puede sostener referencias anteriores, porque no hay ningún almacenamiento personal detrás.

El cierre deja una idea clave para el uso consciente de la IA: entender qué puede “ver” en cada momento es esencial para no atribuirle capacidades que no tiene. Y con este marco claro, se abre el paso al Bloque 6, centrado en aprender a comunicarse mejor con ella, ya sin ilusiones técnicas.

Este capítulo cierra el Bloque 5 dejando una frontera muy clara: la IA puede parecer cercana y continua, pero no acumula pasado. Comprender esto es clave para ajustar expectativas y avanzar hacia una comunicación más precisa y consciente en el siguiente bloque.

Aprendizaje de este capítulo

- La IA no tiene memoria personal. No conserva identidad, experiencia ni intención a lo largo del tiempo.

- Funciona con contexto disponible. Solo puede usar la información que está dentro de la sesión o ventana activa en ese momento.

- La continuidad es aparente, no biográfica. Referirse a algo dicho antes no implica recordar, sino leer lo que sigue estando a la vista.

- El contexto tiene límites. Cuando se supera o cambia la sesión, la información anterior deja de influir en la respuesta.

- Memoria humana y contexto operativo no son lo mismo. La memoria humana mantiene continuidad personal; la IA solo opera con información momentáneamente accesible.

¿Listo para el siguiente paso?

El conocimiento se construye capa por capa.

Continúa tu recorrido por los siguientes bloques, donde profundizarás en cómo funciona la IA, aprenderás a comunicarte con ella y desarrollarás criterio para un uso responsable.